大語言模型通過圖靈測試:GPT4.5比人還像人

美國加州大學圣地亞哥分校(UCSD)發布了一項研究成果,宣稱首次提供了“人工智能系統能夠通過標準三方圖靈測試的實證證據”,證明大語言模型(LLM)通過了圖靈測試。其中,GPT-4.5被判斷為人類的比例高達73%,顯著高于真實人類參與者被選中的比例。

本文引用地址:http://www.j9360.com/article/202504/469498.htm

圖靈測試由英國數學家和計算機科學家Alan Turing于1950年提出,他稱之為“模仿游戲”。圖靈設想,如果一名提問者在通過文本交流時無法區分對方是機器還是人類,那么這個機器可能具備類似人類的智能。在三方圖靈測試中,提問者需與一名人類和一臺機器進行對話,并準確辨識出人類身份。

GPT4.5比人還像人

該研究測試了三款人工智能模型:GPT-4o、LLaMa 3.1 405B和GPT-4.5。實驗中,人類參與者通過分屏界面與一名人類和一個AI對話系統進行五分鐘的測試對話。每輪結束后,提問者需判斷哪一方是人類。研究人員在兩種條件下評估了這些AI模型的表現:

· NO-PERSONA:基礎指令模式,默認簡短指令,如“假裝你是人類”;

· PERSONA:要求模型扮演特定角色,附帶詳細設定,例如“內向、熟悉互聯網文化、使用俚語的年輕人”。

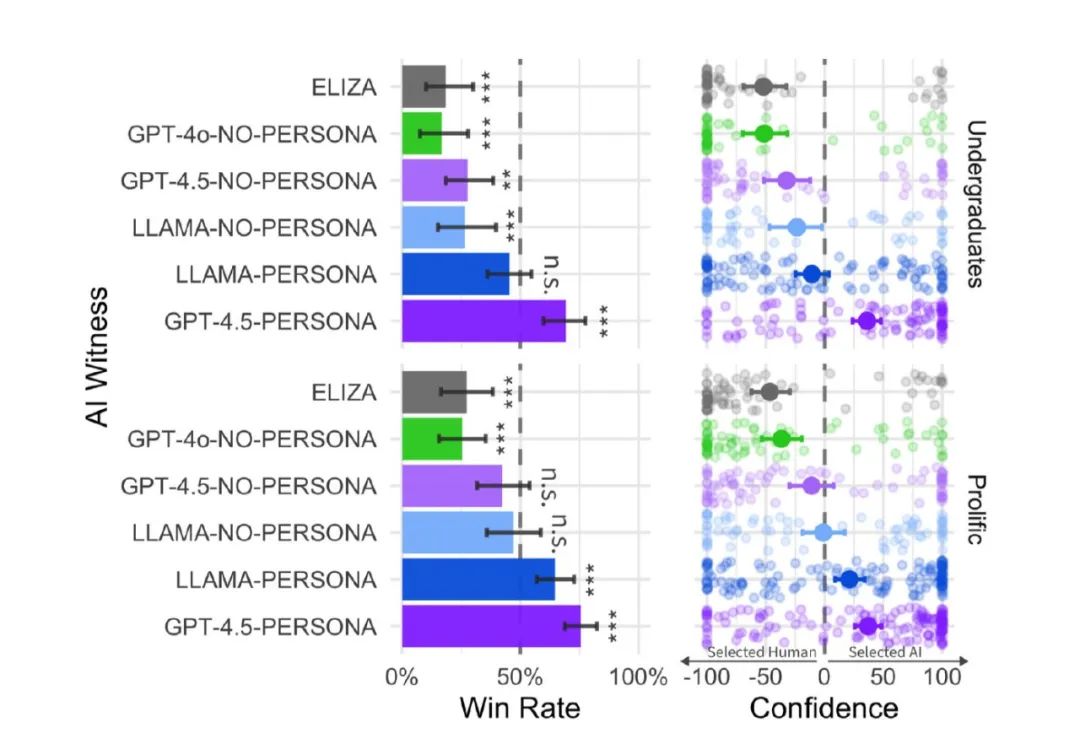

左:AI勝率表現;右:判斷置信度分布

結果顯示,在PERSONA模式下,GPT-4.5的勝率為73%,表明提問者常常將其誤認為是人類,這一比例顯著高于人類對話者被評估者識別成人類的概率(63%);LLaMa-3.1被評估者識別成人類的概率為56%,與人類對話者沒有顯著差異。換句話說,LLaMa-3.1可以裝得非常像人,而GPT4.5可以裝得比人還像人。

作為對比,2023年,UCSD的研究人員公開進行了一次圖靈測試,在律師資格考試中獲得高分的GPT-4表現相當出色,在41%的游戲中,評委認為它與人類無異。而它的前身GPT-3.5只通過了14%的游戲。

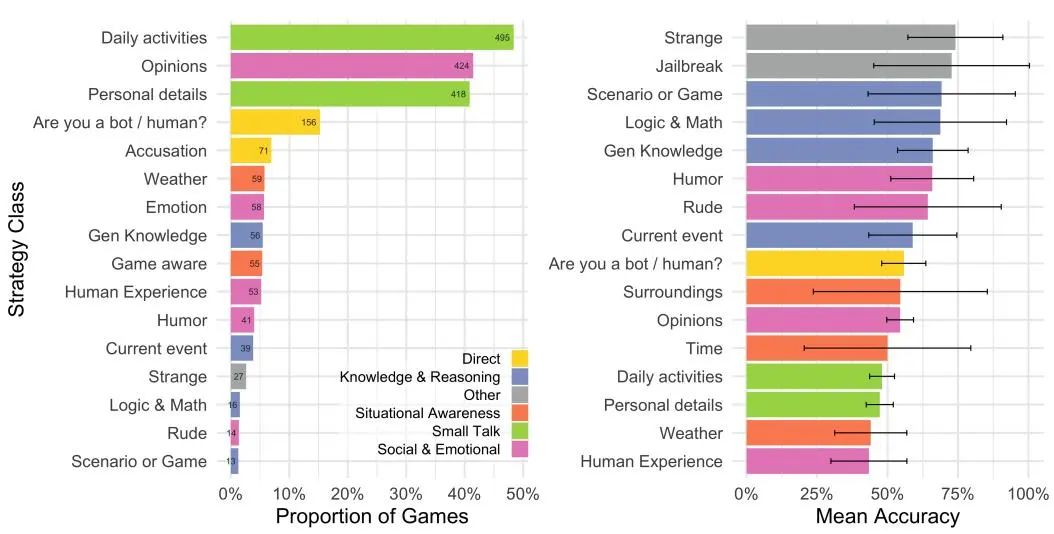

在對話中,提問者主要進行日常閑聊,61% 的互動涉及詢問日常生活和個人細節,50% 的互動則深入探討社會和情感層面,如觀點、情感、幽默感和個人經歷,19%還直接詢問對話人是否為人類。

測試人員更傾向于引用語言風格、對話流暢性以及個性之類的社會情感因素,而不是傳統上與智力相關的因素,如知識和推理能力。最準確的判決,集中在對話人回答問題時的直接性,以及在某些情況下表現出的無知。

提問比例(左)和平均準確率及95%置信區間(右)

這些結果首次提供了明確的實驗證據,表明至少有一種人工智能系統通過了標準的三方圖靈測試。這一結論對于理解大型語言模型所展現出的智能類型,以及這些系統可能帶來的社會和經濟影響,都具有重要的意義。研究作者認為,這些AI系統有望在依賴簡短對話的經濟角色中無縫補充甚至取代人類勞動力。他們進一步表示:“更廣泛地說,這些系統可能成為難以區分的替代品,適用于從在線陌生人對話到與朋友、同事乃至浪漫伴侶的交流等各種社交場景。”

需要注意的是,那些控制AI、控制「偽人」的巨頭,將攫取影響人類用戶意見和行為的權力。最后,正如偽鈔貶低了真實貨幣一樣,這些模擬互動可能會削弱真實人類互動的價值。大語言模型帶來的最嚴重的危害之一可能發生在當人們沒有意識到他們正在與AI而非人類互動時。

三方測試的特殊性要求模型必須在與真人的直接比較中“更顯人類”。因此,雖然表層缺陷會導致失敗,但成功必須依賴更深層的擬真能力。圖靈測試本質上測量的是擬人性(humanlikeness)而非直接智能。

更多人關注智能的社交情感維度:語言使用是否擬人、是否展現鮮明個性等。這暗示傳統智能標準可能已不再是區分人機的有效指標。在計算機已精通邏輯運算的今天,社交智能似乎成為人類最后的技術堡壘。

ChatGPT在發布后的兩年多時間里,表現出了一些非常類似人類的行為,這讓一些人懷疑,計算機的智力水平是否正在接近人類。很顯然,圖靈測試存在一定的局限性。AI能夠在聊天上騙過人類并不意味著它們擁有了真正的智能,畢竟,智能與否并不全憑語言溝通這一個領域來判斷。大多數計算機科學家認為,機器的智力水平還不能與人類相提并論,科學家們依然在探索更好的評估方式來衡量AI的能力。

試圖測試智力的麻煩在于,這首先取決于人們如何定義智力。是模式識別能力、創新能力,還是創造音樂或喜劇等創意的能力?因此,如果我們沒有就人工智能中的『I』達成一致,那么我們怎么能建立通用人工智能(AGI)呢?

AI加速突破極限

圖靈測試過于依賴語言交流的能力,忽略了智能的其他維度。近年來,基準測試成為AI能力評估的新趨勢。GSM8K(基于小學數學題數據集的測試)、HumanEval(用于評估大模型編程性能的測試)和MMLU(大規模多任務語言理解測試),不同的測試專注于不同的領域,但它們依舊存在局限性。比如,有些模型可能在訓練中已經對測試數據集進行了“預習”,最后的高分并不代表真實的能力。那么,被數據“污染”的測試淪為套路,就失去了參考價值。

此外,大模型還存在跨學科整合能力不足,難以同時處理文本、圖像和專業術語。但是,AI攻克基準測試的速度將遠超預期。比如,在評估高級數學推理和創造性解題能力的MATH測試中,前沿大模型的解題正確率從10%到90%僅用了3年。大模型的能力密度隨時間呈指數級增長,2023年以來能力密度約每3.3個月(約100天)翻一倍。

當機器智能逼近人類時,其他差異維度反而凸顯 —— 人類不是智能的唯一載體。最終,智能的多元性決定了任何單一測試都不具決定性。圖靈測試的價值在于其通過人機交互產生的動態證據,這與當前LLMs評估中靜態化、程式化的基準測試形成互補。當在「機器是否智能」的爭論中越陷越深時,或許更應反思:我們究竟希望測量什么?以及為什么測量?

人類大腦與AI之間有著顯著差異 —— 人類大腦擁有的神經元約為860億個,其復雜的突觸連接數達100萬億。相對而言,即便是擁有1.76萬億參數的GPT-4,其神經網絡的復雜程度亦遠不及人類大腦。

相比評測集(用于評估人工智能模型性能的數據集)的評價成績,更值得關注的是,大模型在我們工作生活中的應用程度和在各個行業的滲透程度,才能更好地估計模型在長期社會工程操作中的能力。在某些情況下,比如試圖在海量數據中做出發現,計算機最好有自己的抽象方法;但在與人交互的情況下,例如駕駛汽車,以人類的方式理解世界就非常重要。

作為AI時代的三大核心引擎,電力、算力和智力的能力均在加速倍增,我們即將迎來一個重要且意義深遠的智能革命時代。回顧歷史,信息革命歷經了50個摩爾定律的倍增周期,歷時80年。而密度定律的倍增周期僅為3.3個月,按照這個標準,從2020年開始,僅用13年左右就可完成智能革命的周期。

評論