利用 IP 融合云計算基礎架構

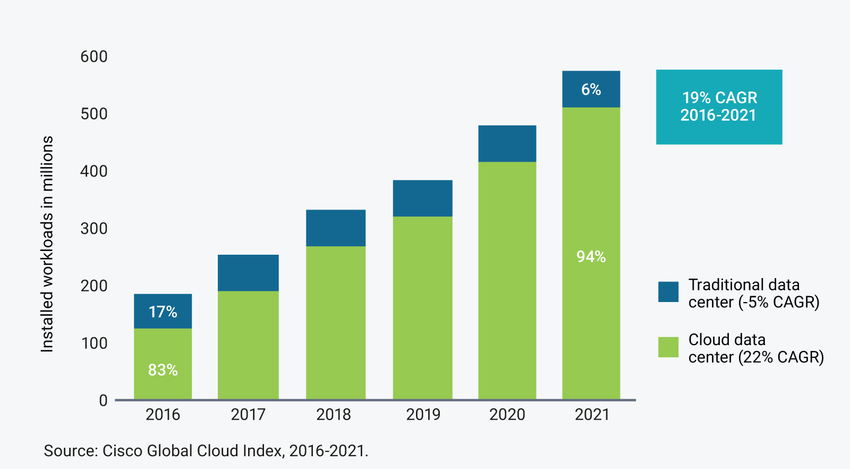

數據中心工作負載和計算應用程序不斷從傳統數據中心遷移到超大規模數據中心。根據 Cisco 全球云指數 測算,“到 2021 年,94% 的工作負載和計算實例都將在云數據中心進行處理”(圖 1)。雖然許多應用程序由超大規模的公共云運營商托管,但許多關鍵任務工作負載和計算實例都是由私有超大規模數據中心托管的。預計從 2016 年到 2021 年,私有超大規模數據中心將以 11% 的復合年增長率增長。雖然大型云提供商開發了定制的機架級系統,但私有云提供商通常采用融合基礎架構 (CI) 或超融合基礎架構 (HCI) 系統來提高效率并降低管理成本。CI 系統和 HCI 系統使私有云提供商能夠通過自動化系統配置和控制、虛擬化計算、存儲和網絡操作,大規模快速部署新系統。向 CI 和 HCI 系統的過渡正在影響半導體片上系統 (SoC) 供應商,促使他們對其服務器處理器、低延遲存儲固態硬盤 (SSD) 和網絡交換機設計加以優化。對 CI 和 HCI 系統的需求推動了一類新型 SoC 架構的產生,這些架構需要最新的 IP 來執行產業功能,如 PCI Express (PCIe)、DDR5、緩存一致性、NVMExpress (NVMe) SSD 存儲和最高帶寬以太網網絡。

本文引用地址:http://www.j9360.com/article/202204/432744.htm

圖 1:在傳統和云數據中心之間分配 Cisco 工作負載和計算實例1

CI 系統將計算、存儲、網絡和管理結合到同一套解決方案中,而不是作為不同的數據中心功能提供。功能全面的 CI 和 HCI 系統實現了整體管理的自動化,使 IT 人員能夠專心管理應用程序,而不是基礎架構。預先集成的機架級系統降低了整體復雜性,以及集成和運營成本。CI 和 HCI 可實現更快的系統部署、更輕松的互操作性和穩定的管理,同時還可減少培訓和技術支持的開銷。為了滿足效率和性能要求,用于構建 CI 和 HCI 系統的 SoC 元件(如設計 IP)正在針對處理、內存性能和連接功能進行優化。

利用 NVMe SSD 和基于 PCIe 的加速器提高性能

基于服務器的 SSD 可以利用在 PCIe IP 接口上運行的 NVMe 協議直接連接到服務器 CPU,同時還能用作緩存加速器,極其快速地緩存頻繁訪問的數據或“熱”數據。高性能的 NVMe SSD 利用極其高效的輸入/輸出操作和低讀取延遲特性在 PCIe 上運行,不僅提高了服務器的效率而且避免了通過外部存儲設備訪問數據的必要性。在 PCIe 上運行、以實現服務器加速的 NVMe SSD 非常適合針對數據庫查詢的私有云的高處理量應用程序。

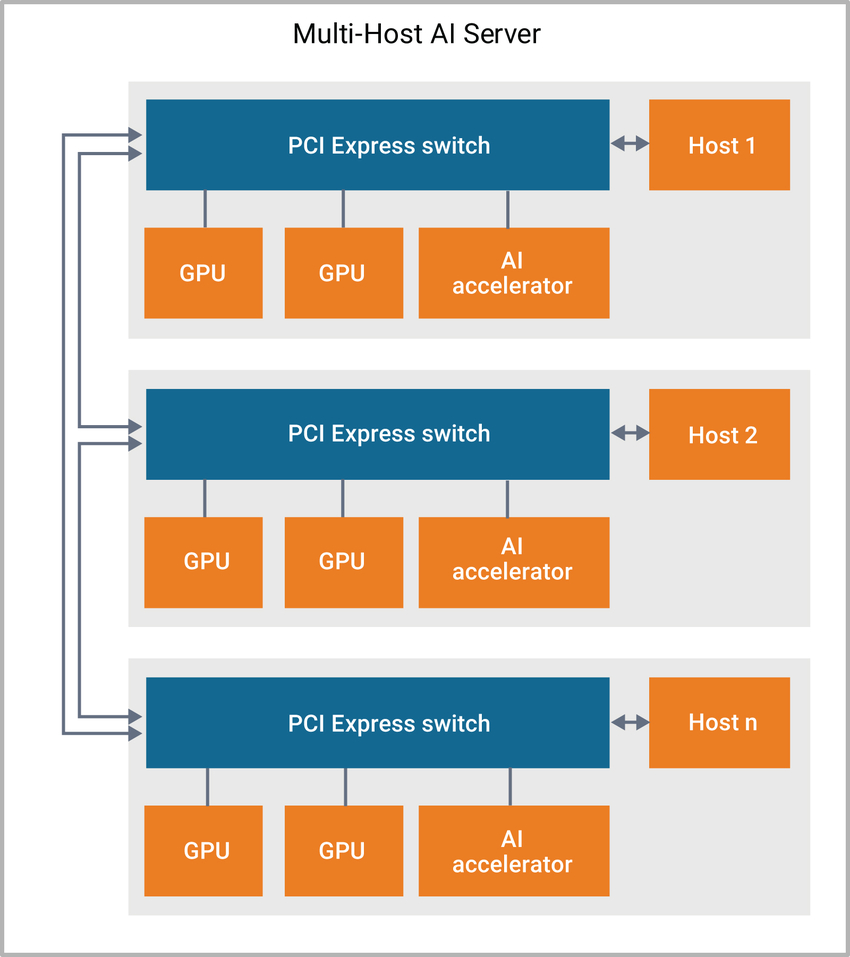

除了使用基于 PCIe 的 NVMe SSD 進行數據庫加速外,CI 和 HCI 系統還使用 PCIe 交換機架構來加速人工智能 (AI) 應用的主機處理器。AI 服務器需要在處理器加速后才能滿足深度學習性能的需求。由于圖 2 所示基于 PCIe 的交換機架構帶來的低延遲特性,將主機處理器連接到 GPU 和基于硬件的加速器可對深度學習算法進行優化。對于需要緩存一致性的應用程序,基于 PCI Express 協議棧構建的加速器緩存一致性互連 (CCIX) 協議可在主機處理器和硬件加速器之間進行高速連接。當前運行速率是 25 Gbps 且很快就提高為 32 Gbps 的 CCIX 通過定義命令,要求在更新內存時即更新系統中的所有組件,確保系統實現單個內存空間,從而減少復制的需求。CCIX 支持交換機拓撲、直連和網格連接。

圖 2:基于 PCIe 交換機架構的多主機 AI 服務器

利用高存儲性能優化應用

經過融合的計算、存儲和網絡系統需要性能最高的 DRAM 解決方案才能在主機處理器上運行虛擬應用程序。整個行業正在從 DDR4 DRAM 過渡到新一代 DDR5 和 HBM2 DRAM。DDR5 解決方案能夠實現高達 4800 Mbps 的數據運行速率,從而能夠和每一個高達 80 位寬的通道的多個雙列直插式存儲模塊 (DIMM) 進行連接,從而加快了深度學習等功能的工作負載速度。另外,DDR5 還具有可靠性、可用性和可維護性 (RAS) 功能,包括內聯或邊帶糾錯碼 (ECC)、奇偶校驗和數據循環冗余校驗 (CRC),旨在縮短系統停機時間。與 DDR5/4 DRAM 相比,HBM2 是一種高效的解決方案,具有很高的帶寬且每比特數據的存取功耗最低。SoC 架構師會針對高帶寬應用選擇 HBM2 存儲器,針對大容量應用選擇 DDR5,或者針對需要高帶寬 HBM2 和大容量 DDR DRAM 的 AI 加速等應用結合使用這兩種存儲器類型。

簡化數據中心網絡

傳統的企業數據中心采用基于樹的網絡拓撲結構,其中包含交換式以太網和 VLAN 標記。這種拓撲結構僅定義了一條連接網絡的路徑,通常用于處理服務器之間的南北數據流量。私有云數據中心使用的 CI 和 HCI 系統采用扁平的雙層葉脊架構,具有25G、50G、100G 或 200G 以太網鏈路,使虛擬化服務器能夠在許多虛擬機之間分配工作流。最新 400G 八通道小型可插拔 (OSFP) 多模收發器(采用 8 條通道 56G PAM-4 PHY IP)通過提供多個 56G 葉脊鏈路,助力數據中心實現高達 400G 的以太網網絡拓撲。業界正計劃向 400G 以太網系統所采用的 112G PAM-4 以太網鏈路過渡,并且期待能夠過渡到 800G 以太網應用。

CI 和 HCI 系統可以使用軟件定義網絡 (SDN) 輕松管理網絡,將控制流與數據路徑分離,從而進一步簡化數據中心的網絡。OpenFlow 等通用軟件棧提供了全行業一致的軟件環境來控制 CI 和 HCI 系統。SoC 設計人員并非擁有專利軟件堆棧,而是在整個私有云數據中心內運行由 OpenFlow 管理的數據,使用戶可以非常輕松地(虛擬)配置網絡,無需實際訪問網絡的硬件設備。

總結

CI 和 HCI 系統將超大規模數據中心的三個核心方面(計算、存儲和網絡)整合到同一套解決方案當中。它們取代了各種各樣經常斷開連接的系統和管理工具。隨著企業數據中心不斷向私有云過渡,服務器和數據中心開始利用虛擬化進行整合,支持將越來越多的工作負載放在數量更少的物理服務器上運行。利用最新的行業 IP 架構和接口協議進行系統融合,從而對低延遲數據庫查詢和深度學習等應用加以優化。CI 和 HCI 系統的硬件在進行集成時使用全新的一套優化處理器、高級存儲器技術 IP、IP 接口、NVMe SSD 和緩存一致性加速器。

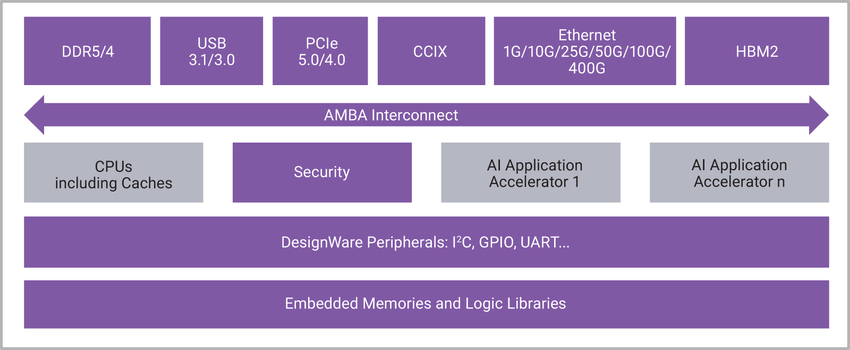

為 CI 和 HCI 系統集成處理器 IP、高級存儲器 IP、連接 IP、NVMe 存儲以及緩存一致性加速器時,SoC 設計人員需要考慮成本、功耗、性能和開發進度等因素的技術權衡問題。圖 3 展示了一個高級 AI 服務器 SoC,其中包含主機處理器、安全算法、系統內存、連接和加速器。

圖 3: AI 加速/服務器 SoC

Synopsys 提供種類齊全、通過硅驗證的優質 IP 產品組合,幫助設計人員開發出面向云計算應用(支持 CI 和 HCI 系統)的 SoC。Synopsys DesignWare? 接口 IP、處理器 IP 和基礎 IP 在高性能、低延遲和低功耗方面都進行了優化,同時支持 16 nm 至 7 nm FinFET 的先進處理技術。

評論