數據中心市場的冰與火:大幅虧損的同時加倍采購GPU

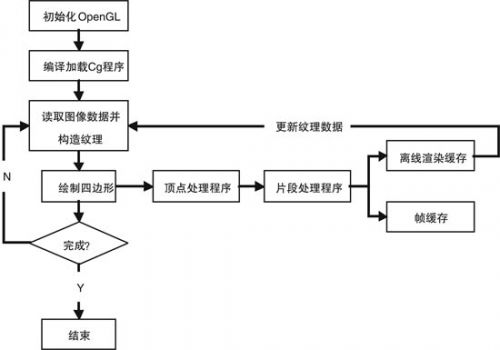

在政治管控介入之前,AI是中美芯片貿易中增速最快的細分市場,中國在2023年至2024年極速擴展AI基礎設施的規模,各類資金齊上陣短短兩年時間建造了數百個新數據中心,預估算力一度占據全球48%左右。2020 年 COVID-19 大流行后以及美元利息走強引發房地產市場的突然暴雷增加了尋找新經濟驅動力的壓力,而 ChatGPT在2022年底的崛起使人工智能似乎是下一件大事。根據 KZ Consulting 的數據,僅在 2023 年,全國就籌建了500 多個數據中心項目。到2024 年底,預計其中至少有150個項目投入運營。地方政府希望推動數據中心作為促進本地區經濟的綠色高效新引擎。國有公司、政府相關投資基金以及私營公司和投資者都渴望支持這些數據中心。

即使在DeepSeek出現之前,數據中心項目的盲目上馬缺乏足夠的規劃很容易導致失敗的場景已經浮現,根據《麻省理工科技評論》在項目負責人和高管中的消息來源,一些設施的建造往往不考慮實際需求或技術標準。這并不特別令人驚訝,因為具有相關經驗的工程師很少見,而且許多高管依靠中間商夸大預測或利用采購來獲得補貼。因此,許多新的數據中心沒有達到預期,因為它們的運行成本高昂、難以填補,并且在技術上與當代AI工作負載無關。按中國本地媒體甲子光年和 36Kr 報道,中國高達 80% 的新建計算資源仍未得到利用。

更復雜的是,一些項目根本沒有計劃從計算服務中獲利。根據《麻省理工科技評論》援引的多份報告和業內人士,某些公司使用 AI 數據中心來獲得政府補貼的綠色能源或土地交易資格。在某些情況下,專門用于 AI 任務的電力被賣回電網進行加價。某些人在項目中獲得了貸款和稅收優惠,但數據中心的場地甚至未被使用。報告稱,到 2024 年底,大多數仍在該行業工作的人的目標是從政策激勵中受益,而不是實際的人工智能工作。

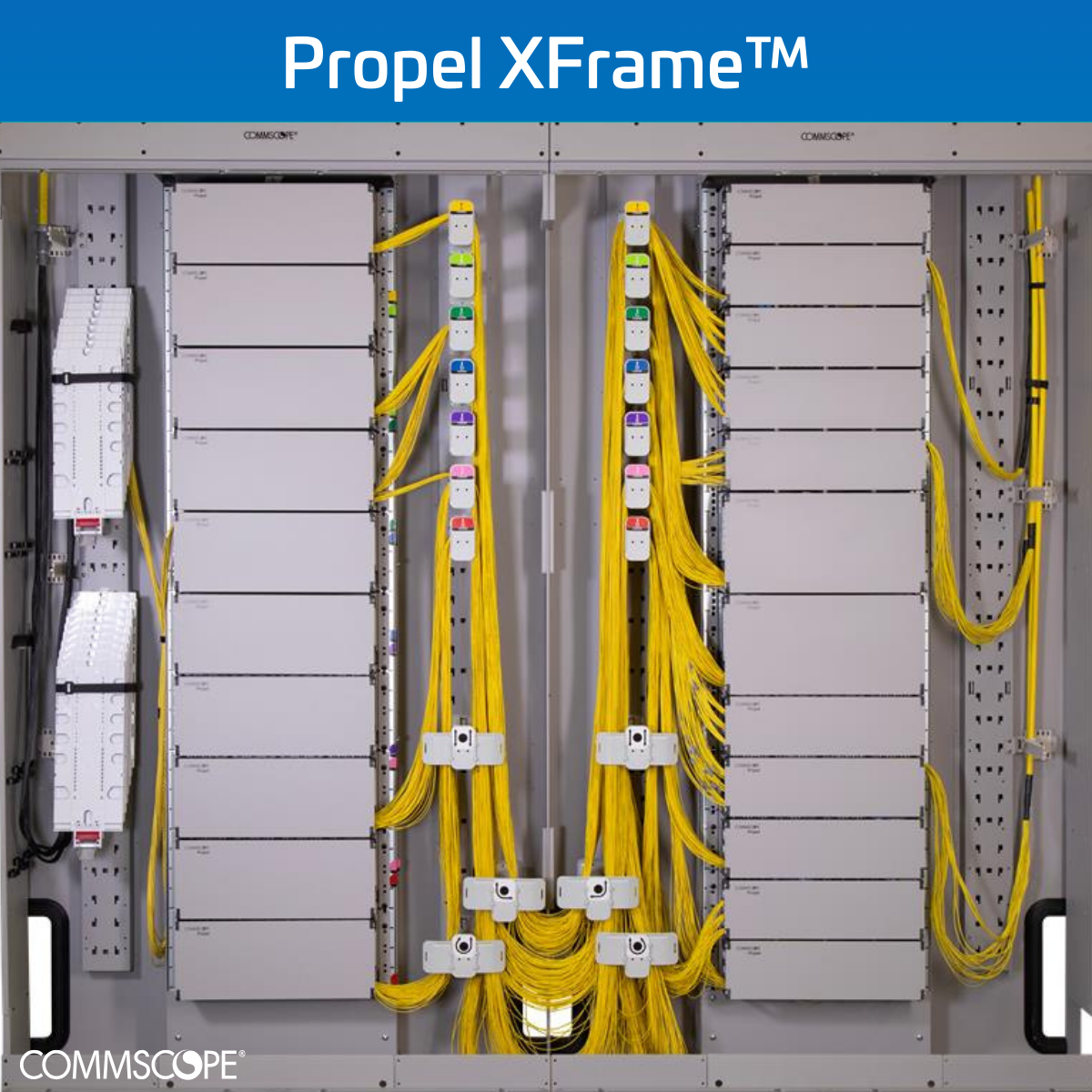

即使對那些緊鑼密鼓推進的數據中心來說,AI的發展實在太快了,一個數據中心從規劃到完全運營一般需要1-2年時間,計劃服役的期限一般是最少8-10年。當 2023 年至 2024 年建造大規模 AI 數據中心時,對 AI 訓練和 AI 推理性能要求的設想需求與我們今天看到的實際需求不同。這就導致了耗資數十億美元的設施現在未得到充分利用,回報率不斷下降,GPU 租賃市場已經崩潰。更糟糕的是,根據《麻省理工科技評論》的說法,隨著市場條件的變化,許多數據中心甚至在完全運行之前就已經過時了。2023年開始ChatGPT讓AI的需求正在轉向推理,因為這是為 AI 模型所有者賺錢的原因。推理工作負載不一定需要基于數以萬計的用于訓練的高端 Nvidia GPU 的大規模集群。相比之下,推理工作負載可以從成本和功耗更低但響應時間更快的專用加速器中受益。因此,一臺配備 8 個 GPU 的 H100 服務器(專為訓練而設計)的月租金從24,000 美元暴跌至10,000 美元。算力租賃價格的暴跌一方面是市場算力需求嚴重供大于求,另一方是多家自有算力中心的AIGC服務商用免費服務直接砸盤,只求在AIGC應用爆火的前期快速搶走市場份額。

中國目前半數運營中數據中心的算力以租賃業務為主,具體到AI方面就是將GP 出租給需要GPU來訓練 AI 模型的中小公司。ChatGPT的出現看似讓整個中國AI的模型圈沸騰,橫亙在太平洋的技術壁壘似乎讓眾多中國團隊看到了未來超越ChatGPT的機會,這似乎是數據中心租賃業務一個非常好的商業起點,但現實的問題是,中國只有少數頂尖公司正在進行大量利用計算能力訓練自己的AI模型,而這其中半數的公司選擇了自己搭建AI數據中心。在這種進退維谷之際,DeepSeek的到來直接加劇了獨立數據中心的窘境。近年來涌現的許多新數據中心都針對預訓練工作負載(在海量數據集上運行的大型持續計算)進行了優化,而不是針對推理進行了優化,推理是運行經過訓練的推理模型以實時響應用戶輸入的過程。推理友好型硬件不同于傳統上用于大規模 AI 訓練的硬件。DeepSeek 崛起以來,許多較小的模型開發者已經放棄了對模型的預訓練或以其他方式改變他們的策略,DeepSeek的開源推理模型 R1 打破了整個AI網絡的業態,其開源推理模型的性能與 ChatGPT o1 的性能相當,但構建的成本則要少得多。

“DeepSeek 是中國 AI 行業的一個清算時刻。緊迫的問題從'誰能制作出最好的大型語言模型'轉變為'誰能更好地使用它們?'“埃默里大學信息系統助理教授 Hancheng Cao 說。

DeepSeek 的 R1 和 OpenAI 的 ChatGPT o1 和 o3 等推理模型的興起也改變了企業對數據中心的期望。借助這項技術,大部分計算需求來自于響應用戶的查詢進行逐步邏輯推導,而不是來自最初訓練和創建模型的過程。這個推理過程通常會產生更好的結果,但需要更多的時間。因此,低延遲(數據從網絡上的一個點傳遞到另一個點所需的時間)的硬件至關重要。數據中心需要位于主要技術中心附近,以最大限度地減少傳輸延遲并確保獲得高技能的運營和維護人員。這一變化意味著在中國中部、西部和農村(電力和土地更便宜的地方)建造的許多數據中心正在失去對 AI 公司的吸引力。即使是某些中部新一線城市,新建的數據中心免費的算力租賃依然難以吸引客戶填滿自己的服務器。

有趣的是,盡管有嚴格的出口限制,以及面對價格暴跌的數據中心租賃價格,英偉達的H100 繼續穩定在中國市場出貨,當然如果我們更嚴謹一點,現在的主力產品是英偉達的H20。

據路透社援引 The Information 的一份報告稱,今年到目前為止,中國科技巨頭們在英偉達的H20人工智能數據中心GPU上總共花費了超過 160 億美元。阿里巴巴集團、字節跳動和騰訊控股是采購熱潮的引領者,紛紛在今年第一季度給英偉達提供了大規模訂單。英偉達報告稱,2025 財年(截至 2025 年 1 月 28 日)來自中國大陸和香港的收益為 171.1 億美元,預估2024年該公司向中國客戶銷售 GPU 的平均每季度收入約為 42.7 億美元。基于此,中國大型公司在 2025 年第一季度購買了幾乎相當于2025年全年銷售額的H20 GPU,如果考慮到英偉達2024年一季度的營收分析,用于AI服務器GPU在中國市場的收益大概是25億美元左右,那么意味著2025年一季度的訂單價值六倍于2024年同期的訂單。

另一個有趣的消息是,服務器制造商之一H3C上周甚至對 英偉達GPU可能出現的短缺表示擔憂,因為它感覺自己無法獲得所需的東西。按理說收到2025年初“DeepSeek橫空出世的影響“以及中國大量AI基礎設施空閑的利空,這種情況本不應出現。但隨著川普上臺后中美兩國對算力基礎設施的較量進入白熱化。中國政府大力推進AI基礎設施的發展以及自主研發的重要性,這讓幾家科技巨頭決定緊跟政策先從硬件基礎搭建入手。阿里巴巴集團宣布計劃在未來三年內投資超過 500 億美元用于云計算和 AI 硬件基礎設施,而字節跳動計劃在 GPU 和數據中心投資約 200 億美元。英偉達的GPU似乎是AI數據中心的首選,在沒有性價比接近的替代品之前,美國包括 OpenAI、軟銀和甲骨文在內的科技公司承諾聯手實施 Stargate 計劃,未來4年在AI方面投資高達5000億以構建先進的數據中心和計算基礎設施,即使按照五分之一投入到算力中心的GPU中,已經確定拿走英偉達未來4年三分之二的產品份額。中國科技公司不太可能提前做好準備。除此之外,我們看到的原因可能還有兩個,一個可能是對美國上屆政府提出的 AI 擴散規則的回應,該規則從 5 月開始禁止中國實體購買美國的 AI GPU。另一個是以新加坡為首的多個市場管制收緊,加劇了科技巨頭們對GPU需求的恐慌。

“如果生成式 AI 將成為殺手級技術,那么基礎設施將成為成功的決定因素,”RAND 的技術政策顧問 Goodrich 說。但是,AI基礎設施這場殘酷的競爭,在AI應用沒有完全定型之前,注定是無休止的投資浪費與財富再分配。

評論