從NN神經網絡理解隱空間

在2023 年1 月刊連載中,我們曾經說明在AIGC領域里,最近幾個很紅的圖像模型,例如DALLE、Imagen 和Midjourney 等, 它們都是基于一種機制:擴散(Diffusion)。經由模型訓練,操作隱空間(Latent space) 的向量,加上隨機輸入中合成新的數據,呈現出令人驚奇的創作,推動了AI 組合的創新或創作。這意味著,關于AI 的生成或創作,大多會涉及隱空間的操作。

現在先從一個基本問題出發,這個問題是:為什么AI會創作呢?由于當今的AI是基于ML( 機器學習),它會向人類學習。繼續探索下去,它向人類學習什么呢?學習人類的做事和創物的經驗直覺。經驗直覺的邏輯是不清晰的,無法經由編程來寫成代碼。那我們該如何把人類的直覺智慧弄進機器(AI) 呢?

答案是:從人類的作品( 如繪畫、音樂、文學作品、食譜、游戲、對話、網絡文章) 中學習作品的形式、風格、情緒等。這些作品被放到網絡上,皆成為大數據(Big Data)。于是,我們就拿這些大數據來給AI 學習,謂之訓練(Training)。

AI 從人類作品中學習到人類專家( 創作者) 的招式(Patterns) 和風格(Style)。如同金庸武俠小說中的楊過、小龍女向大俠們學習了許多武功招式。經年累月,楊過和小龍女學而時習之,逐漸地在內心深處沉淀出招式背后的精華神韻,謂之無招秘境。

一樣地,AI 經過幾十天學習大量作品的創作招式和風格,逐漸地在AI 模型內部的秘境中沉淀出招式背后的精華神韻,這個AI 中的無招秘境,謂之隱藏空間(Latent Space),又簡稱隱空間。

武俠中說:無中生有,從無招中生出千變萬化,無招勝有招。一樣地,AI 也能從其無招秘境中的精華神韻,生出千變萬化的新招式,也就是新作品、新內容(Content)。這種新創作新內容,就謂之AIGC(AI Generated Content)。

除了上述的AI 創作力來自隱空間之外,隱空間也將會是管理大量繁雜模型的利器。例如,可以預測到了2030年之際,AI 模型將更為百花齊放,繁雜多樣,就會導致難以管理,使得管理成本急速升高。

就如同20 世紀八九十年代,經濟生產全球化,碼頭上貨物形形色色,繁雜多樣,非常難管理,導致管理成本急速升高。于是集裝箱(Container) 這個角色就應運而生,大貨輪也出來了,陸地上拖車業也大發利市了。同樣地,到了2030 年,AI 模型的集裝箱角色就很可能會出來。

我認為,AI 的隱空間即將成為AI 的集裝箱。而且在未來數年內,凡是力求掌握潛藏空間,致力于開發控制軟件系統,來有效管理AI 貨柜( 即潛藏空間) 者,將成為AIGC 時代的大贏家。

2 從NN模型深刻理解隱空間

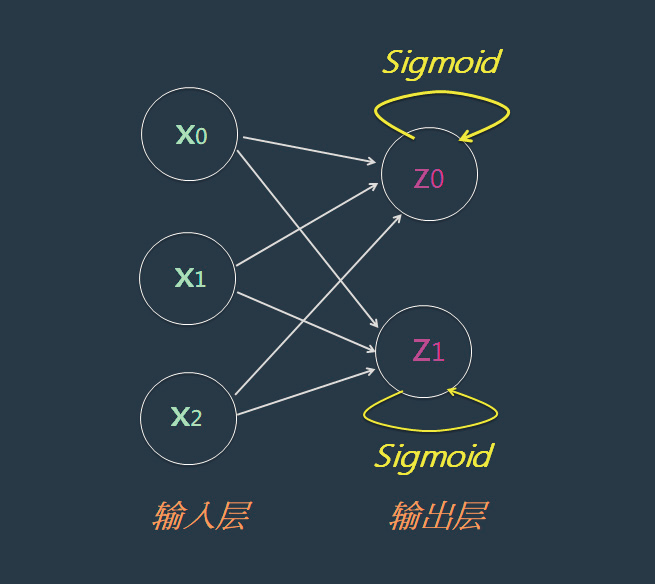

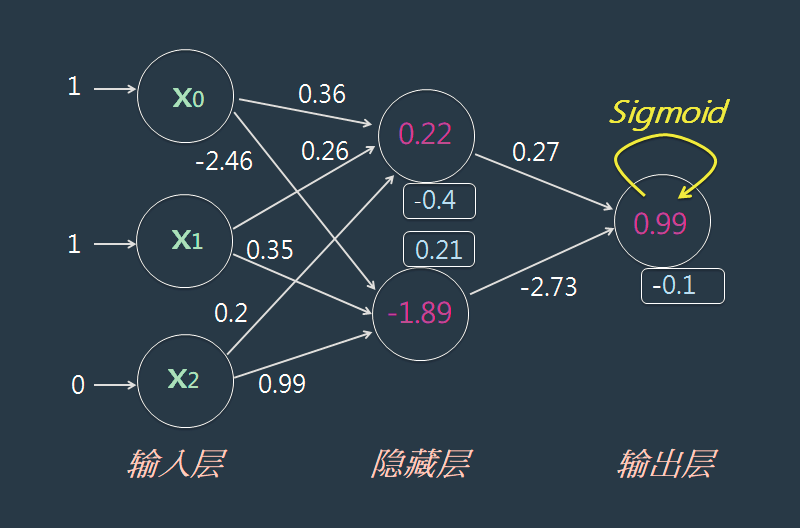

首先從最簡易的單層NN(Neural network) 模型出發。這種簡單模型只含有一層權重(Weight),茲以圖1 這樣的NN 圖形為例。

圖1

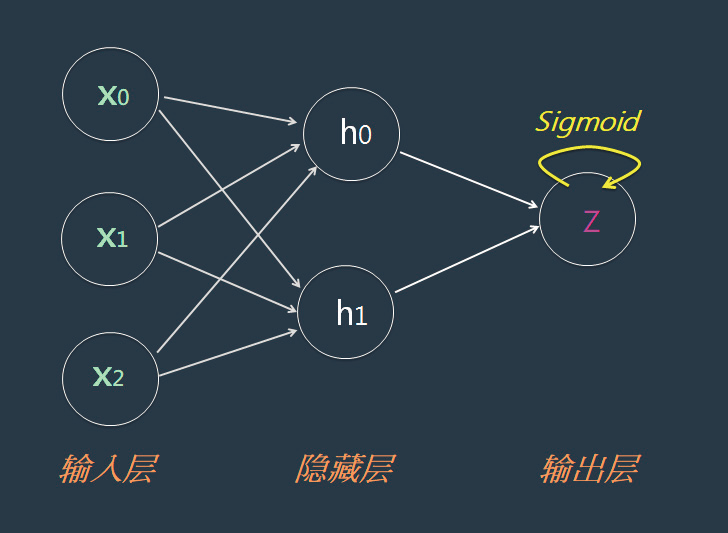

這個模型從X 空間對映到Z 空間。其含有兩層(Layer) 神經元:左邊的X 神經元是輸入(Input) 層,而右邊的Z 神經元,是輸出(Output) 層。然而只有一層權重,所以通稱為:單層NN 模型。接著,就可以繼續擴大為兩層NN 模型,如圖2 所示。

圖2

這個NN模型里包含兩層權重,所以稱為:兩層NN模型。這個中間層,又通稱為:隱藏(Hidden) 層。它就是構成隱空間的核心機制。

3 觀摩:以求職AI為例

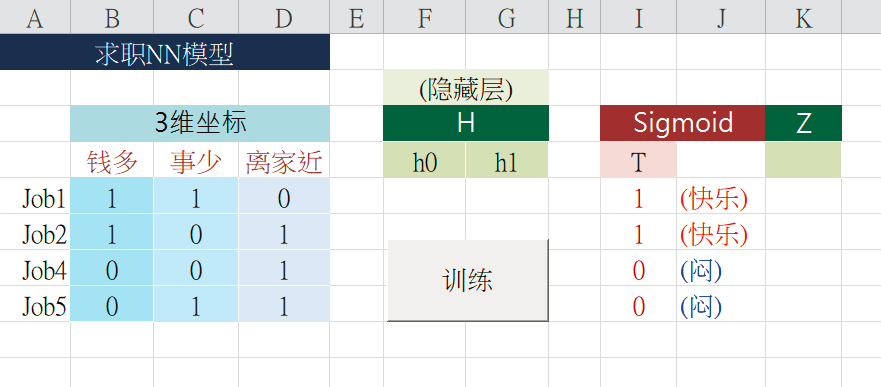

大家常常聽說求職法則是:錢多、事少、離家近。我們如何把這個簡單法則納入NN 模型里,讓它就學會這項法則呢。此時,人們透過T 值來表達他( 她) 心中的規則。

例如有人的求職法則是:“錢多”比“事少”更重要,“事少”比“離家近”更重要。當然,有人比較在意“錢多”,也有人認為“離家近”更重要。人人心中的規則可能各不相同,各自可修改這表格里的數據,表達自己特別的規則,如表1。

表1 三種條件的關聯性

從這些數據可以看出來,這位人士心中的偏好是:“錢多”比“事少”更重要,“事少”比“離家近”更重要。只要給NN 模型一些訓練,它就能認知到這位人士心中的規則了。雖然它聽不懂人類的語言,也不需要寫Python語言告訴它;只需要提供數據給它學習就可以了。

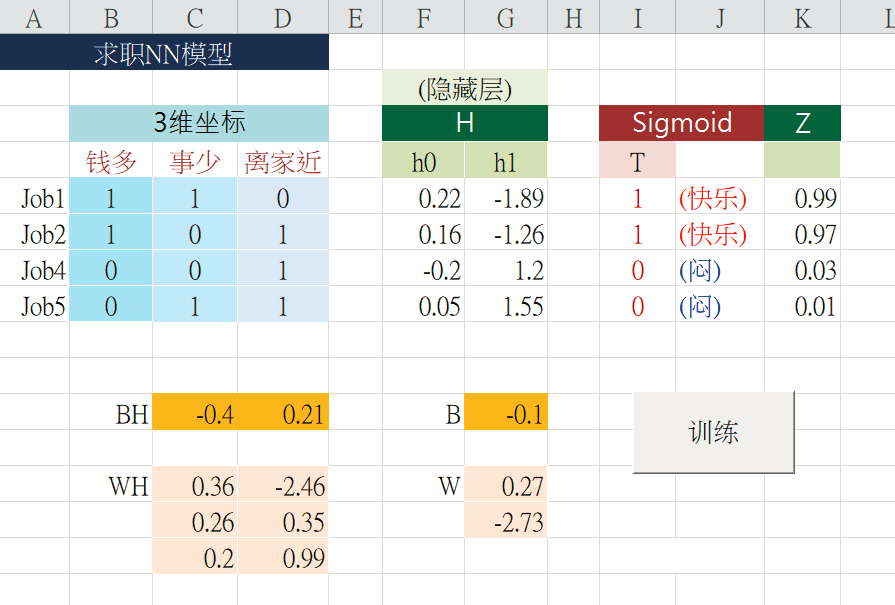

這個NN模型里的隱藏層,并沒有使用Sigmoid()激活函數。一樣地,只要按下這個< 兩層一起學習>按鈕,ML就會尋找出隱藏層的權重WH和BH,同時也尋找出輸出層的權重W和B如表2。

表2 輸出權重訓練邏輯示意

然后將輸入層X空間,對映到隱藏層H空間,再對映到輸出層的Z空間。于是得出H和Z預測值。例如,將X=[1, 1, 0] 經由兩層權重的計算流程如圖3所示。

圖3

最后計算出Z 值為:0.99。這就是典型的兩層NN模型了。在訓練的過程中,每一回合都會修正輸出層的權重,也會修正隱藏層的權重。所以這兩層權重是同步成長的。

4 多層的NN模型

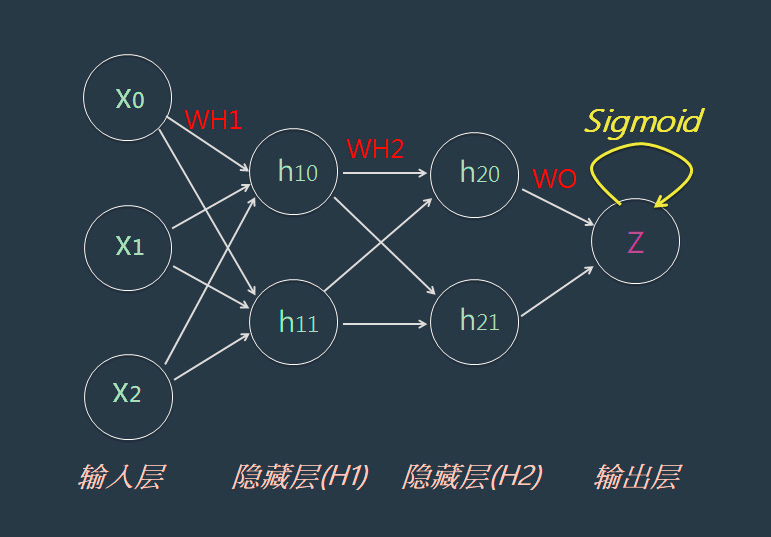

剛才的范例是兩層NN 模型,它只含有一個隱藏層(Hidden Layer)。有些情境下,常常1 個NN 模型里,需要含有更多個隱藏層,這種模型就通稱< 多層NN 模型>,或稱為< 深度NN 模型>。

例如,可以繼續擴大上述的NN 模型,讓它含有兩隱藏層,茲以NN 圖形表示如圖4 所示。

圖4

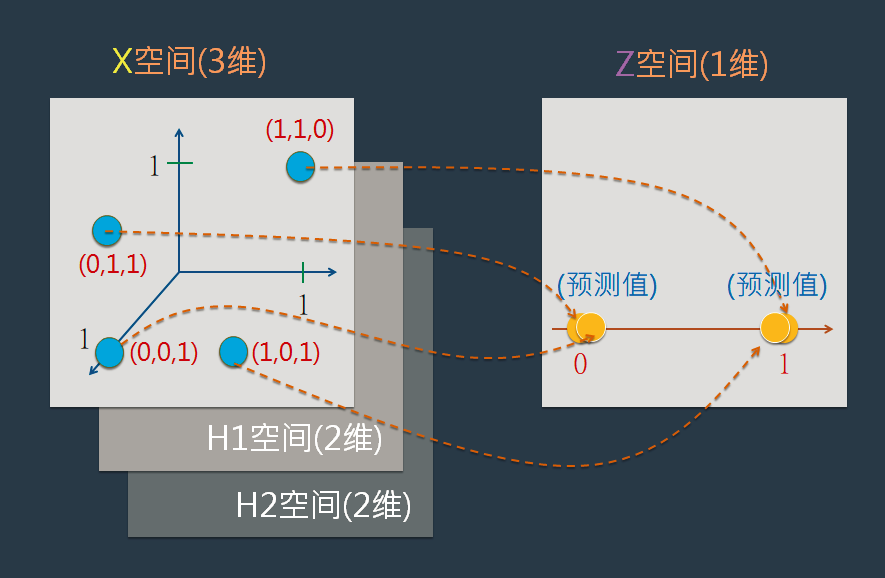

在訓練及預測過程中,將輸入層X空間,對映到隱藏層H1空間,再對映到隱藏層H2空間,再對映到輸出層的Z空間。在隱藏層H1和H2里, 仍然使用X *W+B=Y 公式來表達其對映關系;而在輸出層則使用X*W+B=Y 和 Sigmoid(Y) =Z公式來表達其對映關系。并計算出在Z空間里的預測值,如圖5。

圖5

此外,在許多情境里,常常需要建立更多個隱藏層,例如著名的ResNet 模型就多達數十個隱藏層,也是常見的多層深度NN 模型。而基于這種模型的機器學習,就通稱為:深度學習(Deep Learning)。

5 結束語

以上介紹過了隱藏層(Hidden Layer) 的觀念,位于這隱藏層的空間,就簡稱為:H 空間。其正式名稱是:隱空間(Latent Space)。例如,在兩層NN 模型里,其中的隱藏層(H 空間) 就是:隱空間。茲再復習一下,隱空間相當于金庸小說里武林大俠的< 無招> 境界。唯有高度掌握< 無招> 才能解釋千變萬化的招術。君不見,在AIGC領域里,AE、GAN和Diffusion等新潮技術,都是潛藏空間威力的表現。

(本文來源于《電子產品世界》雜志2023年3月期)

評論