微軟重磅官宣推出 AI 自研芯片,與H100、特斯拉D1等AI芯片性能對比

北京時間周四凌晨 1 點,微軟(Microsoft)Ignite 技術大會在西雅圖揭幕,該公司 CEO 薩蒂亞·納德拉進行了接近 1 個小時的開幕演講,介紹了 AI 龍頭取得的最新進步。

本文引用地址:http://www.j9360.com/article/202311/453077.htm此次,微軟發布了首款自家研發的人工智能(AI)芯片 Maia 100,以及應用于云端軟件服務的芯片 Cobalt。兩款芯片將由臺積電代工,采用 5nm 制程技術。

目前,AI 芯片市場由英偉達(Nvidia)獨霸,有大量 AI 芯片需求的科技大廠極力尋求可替代的供應來源; 微軟自行研發,希望增強 ChatGPT 等生成式 AI 產品的性能,同時降低成本。

Cobalt 是基于 Arm 架構的通用型芯片,具有 128 個核心,Maia 100 為特定 AI 加速器,用于云端訓練和推理的,晶體管數量達到 1050 億個。這兩款芯片明年將導入微軟 Azure 數據中心,支持 OpenAI、Copilot 等服務。

目前,英偉達在 AI 芯片市場的市占高達 80% 左右,需求強勁,高端產品一顆有時可賣到 3 萬到 4 萬美元。日經亞洲指出,用于 ChatGPT 的芯片被認為大概就需要有 1 萬顆,這對 AI 公司是個龐大成本。

負責 Azure 芯片部門的副總裁 Rani Borkar 表示,微軟已開始用 Bing 和 Office AI 產品測試 Maia 100 芯片,微軟主要 AI 合作伙伴、ChatGPT 開發商 OpenAI,也在進行測試中。

彭博資訊指出,微軟的多年投資顯示,芯片對于在 AI 和云計算領域取得優勢至關重要。自研芯片可以讓微軟從硬件中獲得性能和價格優勢,還可以避免微軟過度依賴任何一家供應商。目前業界對英偉達 AI 芯片的爭奪戰,更加凸顯了這個問題。

在微軟進軍自研處理器之前,在云計算市場上的競爭對手也采取類似策略。亞馬遜在 2015 年收購了一家芯片制造商,并提供多種云端運算與 AI 芯片服務。Google 從 2018 年開始,也已讓客戶使用其 AI 加速處理器。

除了發布的這兩款芯片,業界一直在傳,微軟有一個代號為「Athena」的 AI 芯片項目,2019 年就開始了內部研發。據悉,微軟希望 Athena 芯片的性能優于目前從其它供應商處購買的芯片,從而節省其在昂貴的 AI 業務上的時間和成本。

有市場評論認為,微軟 AI 芯片立項的時機很巧,正好在微軟、OpenAI 等公司培養的大型語言模型已經開始騰飛之際。兩位知情人士表示,OpenAI 的 ChatGPT 聊天機器人的發布讓人們興奮──根據分析師預估,截至今年 1 月,也就是 ChatGPT 發布兩個月后,該機器人已經擁有超過 1 億用戶──這促使微軟加快 Athena 的研發和推出。

知情人士說,微軟最快可以在明年讓 Athena 在公司和 OpenAI 內部廣泛使用。不過其中一名知情人士表示,微軟內部仍在爭論是否會向其 Azure 云計算服務的客戶提供這些芯片。

如果微軟確實走向其云計算客戶提供芯片,它還必須為其打造比英偉達當前產品更具吸引力的軟件,英偉達在該領域已深耕 15 年,其軟件產品已在全球廣泛使用。

調研公司 SemiAnalysis 的首席分析師 Dylan Patel 估算,ChatGPT 的運營成本為每天約 70 萬美元或每次查詢 0.36 美元。Patel 說:「大部分成本來自其所需的昂貴服務器。和英偉達產品相比,若 Athena 具競爭力,可以將每個芯片的成本降低三分之一。」

Patel 還表示,微軟希望他們在所有的應用程序中都使用這個大型語言模型,包括 Bing、Microsoft 365 和 GitHub。如果采用英偉達現成的軟件進行大規模部屬,光芯片這一項成本每年就要燒掉數百億美元。

微軟并不認為自己的 AI 芯片可以廣泛替代英偉達的產品。有分析認為,微軟的這一努力如果成功的話,也有可能幫助它在未來與英偉達的談判中更具優勢。

此次,微軟還推出了名為 Sidekicks 的定制液冷硬件,該硬件安裝在包含 Maia 服務器的機架旁邊的機架中。一位發言人表示,該公司無需改造即可安裝服務器機架和 Sidekick 機架。

在網絡連接方面,為了滿足 AI 和未來工作負載的要求,微軟推出了新一代空芯光纖(Hollow Core Fiber),利用空氣作為光纖的導光介質,能夠將傳輸速度提高 47%。當然這也與微軟的「鈔能力」有關,公司在去年 12 月底收購了這條賽道的領跑者英國 Lumenisity。

會上,納德拉宣布 Azure Boost 數據中心硬件也將正式投入商用。該系統能夠將存儲和網絡進程將主機轉移到專用硬件和軟件上,從而提高速度。

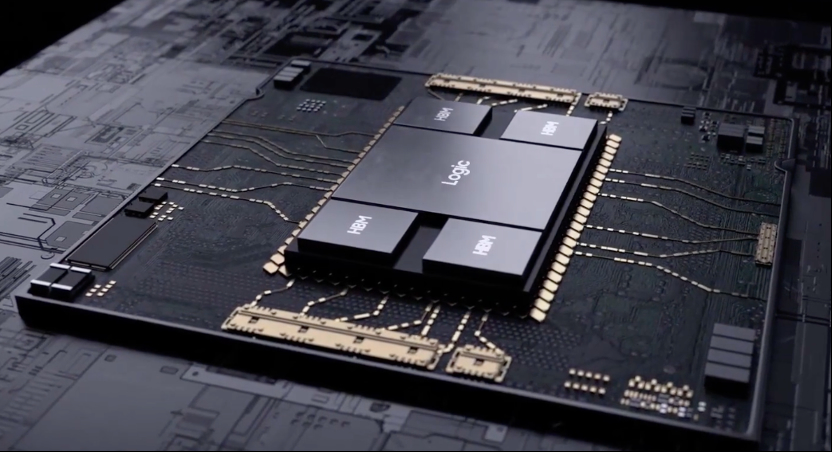

據千芯科技董事長陳巍博士分析,就 Maia 100 性能來看,MXFP4 算力達到了 3200TFLOPS,MXInt8 算力達到 1600TFLOPS(這里有可能是新聞筆誤,因為 INT8 算力一般按照 TOPS 單位)。SIMD 算力為 48TFLOPS,具備 140MB L1 緩存和 448MB L2 緩存,HBM3 容量為 64GB,TDP 功耗 860W,采用 TSMC N5 工藝,面積 820mm^2,105BIllion 晶體管。

對比一下 Maia 100 和其他幾個家世顯赫的芯片性能,可以看到 Maia 具有大量的片上 SRAM(單芯片合計 588MB),甚至超過了特斯拉 D1,有可能是存算一體(近存計算)架構的 AI DSA。初步猜測其架構和液冷方式與特斯拉 Dojo 接近。

緊密聯系合作伙伴

基于微軟與 AI 軟件龍頭 OpenAI 的緊密關系,所以微軟 Azure 云服務也將在第一時間向用戶提供 OpenAI 的最新產品,例如 GPT-4 Trubo 和多模態能力,以及基于 GPT-4 的微調。

微軟也在今天宣布推出「MAAS」產業模式(Models as a Service/模型即服務),用戶可以直接通過微軟的服務來調用 API、微調和部署各類開源大模型。微軟也已經與 Meta 等一眾大模型開發商達成合作,將 Llama 2 等知名 LLM 作為一項服務推出。

納德拉宣布,Azure 云將發布英偉達的 AI 工坊服務(AI foundry service),為此他還請來了黃仁勛,講述兩家 AI 巨頭從硬件到軟件的全面合作。

據悉,英偉達 AI 工坊涵蓋英偉達的 AI 基礎模型、NeMo 框架和工具,以及英偉達 DGX Cloud AI 超級計算和服務三大要素。微軟用戶將可以在 Azure 云上利用英偉達的 AI 軟件生成并部署模型。

黃仁勛表示,AI 的第一波浪潮源自 OpenAI 等一批創業公司,而現在整個產業已經進入了第二波浪潮,由微軟 Copilot 推動的企業級 AI。在他看來,第三波也是最大的那一波將會是整個世界的重工業數字化,并從生成式 AI 中獲益。

評論