盤點在使用openvino過程中遇到的一些問題,如何解決的-第2篇

1.問:問一下,keras框架下訓練的hdf5模型,轉換至lr模型。需要先轉pd模型,然后轉IR么?

本文引用地址:http://www.j9360.com/article/202204/432865.htm答:不行,要轉成TF模型,pd模型就是tf的,.pd格式,可以試試

問:那tf轉IR,直接用openvino自帶的就可以轉換吧

答:對的

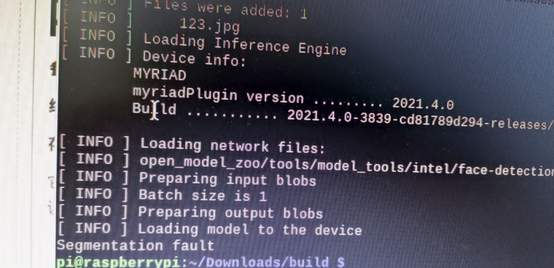

2.問:在樹莓派3上面,跑openvino的人臉識別demo,插上了intel神經計算棒,出現這個錯誤,有大佬知道咋回事嗎

答:估計輸入有問題,給的圖片估計有問題

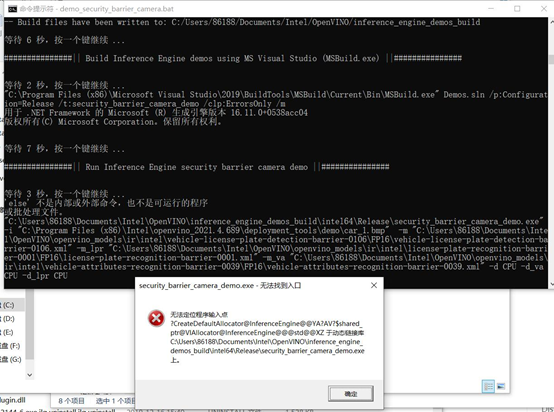

3.問:求解決一個安裝問題,運行demo_security_barrier_camera.bat的時候報的錯

答:下載離線安裝包,全部走默認安裝,完了配置環境變量,就行了啊

問:不是,我感覺是電腦缺dll文件,無法連接到動態鏈接庫

答:附加目錄、庫目錄啥的配好了應該沒問題。

其他答1:初始化環境變量了嗎?

問:初始化環境變量加了,cmake,python3.7,vs2019,都安裝配置了

其他答1:別的demo可以正常運行嗎?

問:都不能運行,都是報同樣的錯誤,打算把anaconda,python,cmake,vs全卸了,重新裝了

其他答2:重裝系統吧

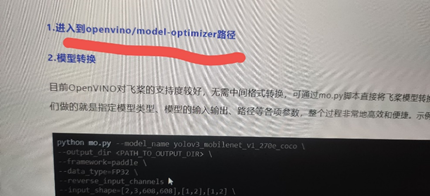

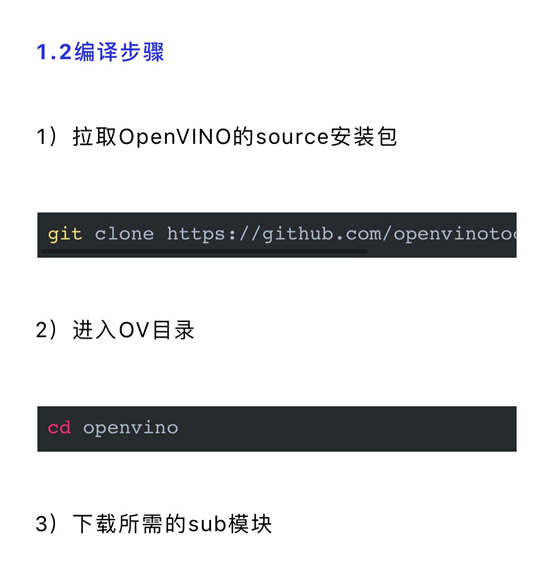

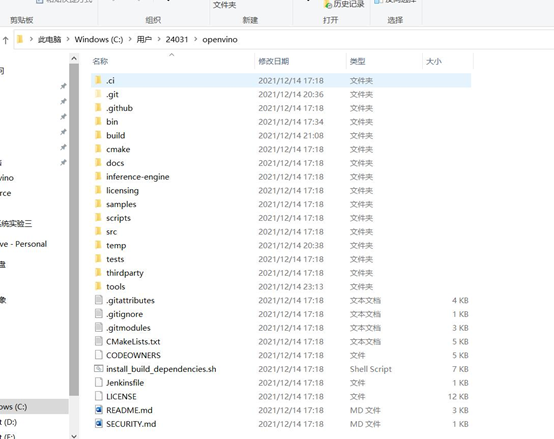

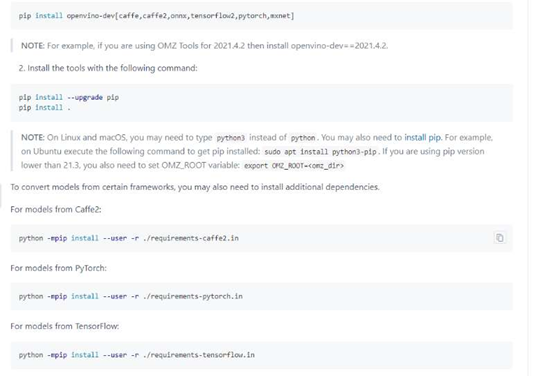

4.問:求助 有人用過paddlepaddle + openvino嗎,按照官網來找不到這個文件夾怎么辦

答:參考哪個官網來的?openvino還是paddlepaddle?附鏈接看看

問:https://www.paddlepaddle.org.cn/support/news?action=detail&id=2681

答:是否執行完了這一步,clone完成了就會有

回:這些我做過的

答:https://github.com/openvinotoolkit/open_model_zoo/tree/master/tools/model_tools 可以單獨下載open_model_zoo模塊,里面有模型優化器

5. 請問一下大家,跑前向推斷的時候都沒有報錯,跑到這一步ie_exec_network_create_infer_request(exe_network, &infer_request);的時候,也不報錯,也沒有log,直接就退出了,可能是什么原因?

答:在推理的輸入階段報錯的話,建議你查看是否是openvino環境沒有配置好,導致IEplugin加載失敗?或者推理硬件比如cpu沒有指定?

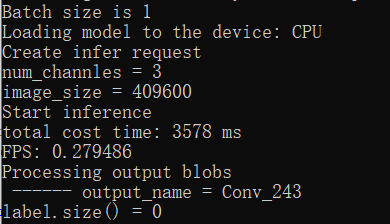

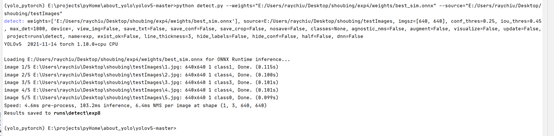

6. 問:C++的一張圖片推理3s

答:用CPU慢啊,模型大

問:應該不是模型大的原因吧,我用yolov5自帶的detect檢測很快,不知道infer_request->Infer();這一步為啥執行這么久,onnx用yolov5自帶的detect檢測0.1s,轉了IR后用C++ openvino推理就3s多了

答:有可能是模型轉換過程中層的問題,可以用openvino直接推理onnx來對比下推理延遲,和IR文件的推理差別大不大

評論