深度學習算法有望在FPGA和超級計算機上運行

隨著人工智能技術的發展,各大科技公司都加大在深度學習上的投入,而作為美國國家科學基金會也同樣如此,當下,它通過資助美國幾所大學的研究人員,促進深度學習算法在FPGA和超級計算機上運行。雖然目前看到的還只是代表了深度學習的一個趨勢,但是隨著各大科技公司的商業運營以及更多的深度學習走進大學研究中心以及國家實驗室,對深度學習的發展起到積極的促進作用。

本文引用地址:http://www.j9360.com/article/201710/365706.htm以下為原文:

機器學習在過去的幾年里取得了很大的進步,在很大程度上歸功于計算密集型工作負載擴展新技術的發展。NSF最新的資助項目似乎暗示我們看到的可能只是冰山一角,因為研究人員試圖將類似深度學習的技術擴展到更多的計算機和新型的處理器上。

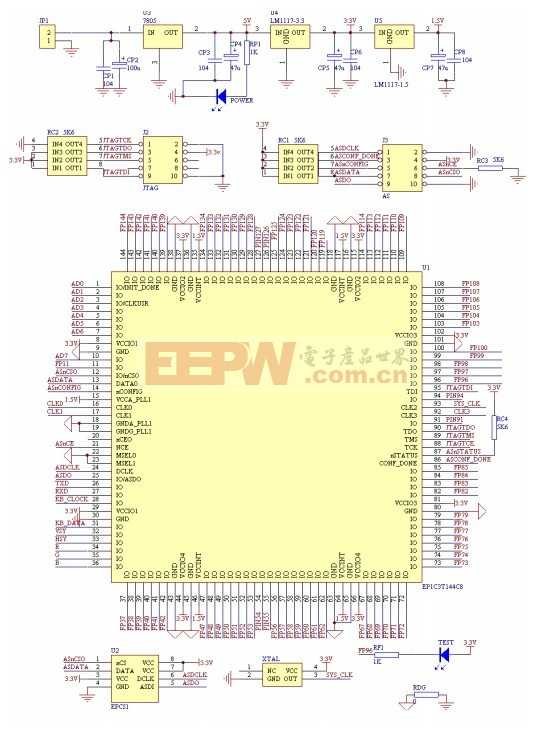

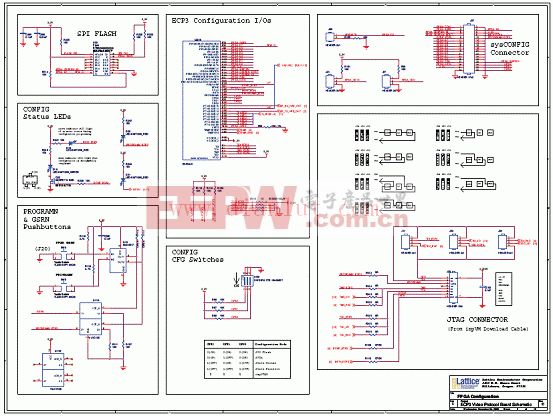

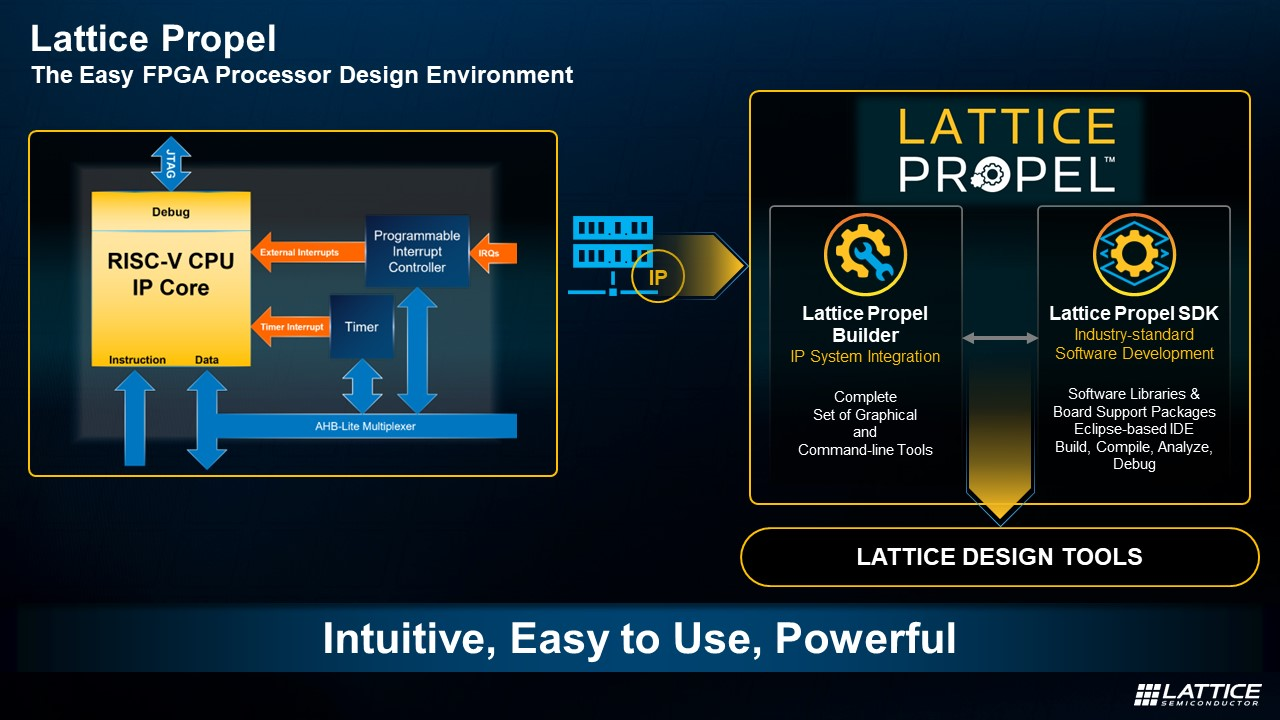

由紐約州立大學石溪分校團隊實施的一個特別有趣項目,該項目旨在證明FPGA(現場可編程門陣列)優于GPU,他們發現深度學習算法在FPGA上能夠更快、更有效地運行,這突破了當前傳統的認識。

根據項目概要:

研究人員預計在GPU上算法的最慢部分,運行在FPGA上將實現明顯的加速,同時,在GPU上算法最快的部分在FPGA上將有類似的運行性能,但是功耗會極低。

實際上,除了不同于GPU,在硬件上運行這些模型想法并不新奇,例如,IBM最近憑借一個新的brain-inspired芯片轟動一時,它聲稱可以完美支持神經網絡和其他cogniTIve-inspired工作負載。微軟在今年7月演示了它的Adam項目,這個項目是重新修改了一個流行的深度學習技術使其在通用英特爾 CPU處理器上運行。

由于其可定制的特點,FPGA有著獨特的優勢,今年6月,微軟解釋它如何通過卸載某些進程部分到FPGA來加快Bing搜索。當月晚些時候,在Gigaom的Structure大會上,英特爾宣布即將推出的混合芯片架構將FPGA在CPU共置在一起(實際上它們會共享內存),這主要針對專業大數據負載與微軟必應這樣的案例。

然而,FPGA對于深度學習模型來說并不是唯一的、潛在的基礎架構選擇。NSF還資助紐約大學的研究人員,讓他們通過基于以太網遠程直接內存訪問技術來測試深度學習算法以及其他工作負載,這在超級計算機上廣泛使用,但現在要將它帶到企業系統,RDMA連接器通過直接發送消息到內存,避免了CPU、交換機和其他組件給進程帶來的延遲,從而加快計算機之間傳輸數據速度。

說到超級計算機,另一個新的NSF資助項目,由機器學習專家斯坦福大學(百度和Coursera)的Andrew Ng和超級計算機專家田納西大學的Jack Dongarra以及印第安納大學的Geoffrey Fox領導,旨在使深度學習模型利用Python可編程,并且將它帶到超級計算機和擴展云系統。據悉,這個得到了NSF將近100萬美元的資助的項目被稱為Rapid Python Deep Learning Infrastructure。

RaPyDLI將被構建成一套開源的模塊,可以從Python用戶界面訪問,但是可以放心地在最大規模超級計算機或云的C / C++或Java環境中通過互動分析和可視化執行。RaPyDLI將支持GPU加速器和英特爾Phi協處理器以及廣泛的存儲技術包括Files、NoSQL、HDFS和數據庫。

目前做的所有工作都是讓深入學習算法更容易并且改善它們的性能,這三個項目只是一小部分,但是如果這些技術能夠被科技巨頭用到商業領域,或者進入研究中心以及國家實驗室利用計算機解決真正的復雜問題將是非常有益的。

評論