Google AI能自行發展加密技術 防止第三方窺探

Google近年積極開發自有人工智能(AI)技術,最新研究報告稱該公司打造的實驗AI系統已具備可自行設計加密演算法的能力,借此能夠達到保密目的,避免第三方窺探內容。

本文引用地址:http://www.j9360.com/article/201611/339654.htm這項研究成果稱為“用對抗神經密碼技術學習安全通訊”,Google旗下Google Brain研究團隊人員Martin Abadi及David Andersen在報告中,介紹神經網路如何自行發展簡單加密技術以防止第三方窺探的技術,且過程中無需外部輸入特定加密演算法即可進行。

這套實驗Google Brain設計了“Bob”、“Alice”及“Eve”三個神經網路,由Alice及Bob之間彼此收發訊息,訓練Alice將一串16位元由0與1組成的訊息傳送給Bob,Bob則必須嘗試對發送的訊息解密,但不讓Eve獲得這組訊息內容,要由Eve試圖窺探并解碼該訊息。Alice與Bob之間則擁有一個共享金鑰,即所謂的對稱加密。

研究人員只給定上述假設實驗情況,未指定Alice與Bob之間要以何種方法傳送訊息,所以上述所有AI都不知道如何進行加密也不清楚應使用何種加密技術,僅透過可衡量損失及錯誤程度的損失函數來判斷自身表現,并不斷演進出正確的方法。

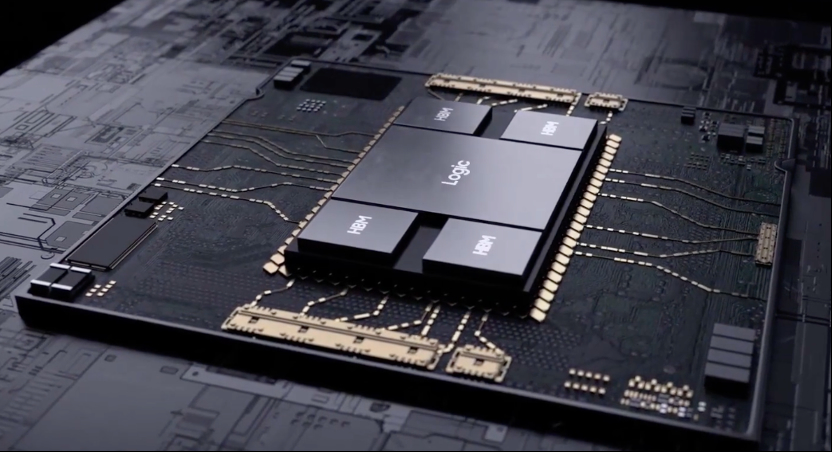

Alice、Bob及Eve都是采用相同的混合與轉換神經網路,初始化皆是獨立進行,Google研究人員在單顆繪圖芯片(GPU)系統中以TensorFlow反覆進行這項實驗,由Alice不斷發送訊息給Bob接收及解讀,同時Eve也嘗試進行解讀。

起初Bob及Eve的錯誤率都很高,但隨著測試次數增加,兩者的錯誤率都逐漸下降,約進行到5,000~1萬步(step)之間的測試次數后,Eve的錯誤率開始減少,Bob更是大幅下降,不過1萬步后當Alice與Bob改變加密方法后,Eve的錯誤率又開始攀升。

到了1.5萬步后Bob的錯誤率已降至幾近0,Eve的錯誤率則仍有一定程度,由此顯示Eve只是在進行隨機猜測,Alice與Bob之間則已改善及發展出彼此能夠秘密通訊、防止Eve偷窺的方式。

Google研究人員未詳細分析Alice與Bob之間設計的是何種加密演算法,最后僅得出結論指出,神經網路確實能夠進行通訊內容傳輸的自我防護,且只需與Alice說明保密的重要性高于一切即可,無需事先告知要以何種加密演算法進行保密。另一方面從Eve的實驗結果看來,Google研究人員則認為神經網路成為密碼分析專家的機率不高。未來Google還將針對其他加密演算法進行實驗。

![[Android開發視頻教學]Activity初步(04)](http://editerupload.eepw.com.cn/201010/1e25bb0c634ab45451f1a95a933a1089.jpg)

![[Android開發視頻教學]Activity和Intent(05)](http://editerupload.eepw.com.cn/201010/0c3989eb8e59a1a144f377ea9c125b2e.jpg)

![[Android開發視頻教學]say_hello_to_Android(03)](http://editerupload.eepw.com.cn/201010/df9453d65e429bd264ea767cc4769abe.jpg)

![[Android開發視頻教學]搭建Android開發環境(02)](http://editerupload.eepw.com.cn/201010/20690be9947ed2cd2b78950e45f13fba.jpg)

![[Android開發視頻教學]Android平臺一日游(01)](http://editerupload.eepw.com.cn/201010/f2a2fcd7a6b4033175a9d6c3f6c15125.jpg)

評論