如何使用LLM建立行業KG(知識圖)

1 KG與LLM完美結合

大語言模型(LLM)在各種應用領域中已經取得了顯著的成功,但是它常常無法捕捉和掌握最新的事實知識。而另一方面,知識圖(Knowledge Graph,簡稱:KG)則擁有豐富的專家知識和事實知識,但它很難以構建,又又不足以處理現實世界知識圖譜的動態變化性質和因果推論功能等。因此,自然而然地將KG 和LLM結合起來,各自發揮優勢,相輔相成,締造完美組合。

2 KG協助LLM:降低LLM幻覺

大家都知道,LLM 常有幻覺(Hallucination)現象,這是源于LLM 缺乏:準確性、可解釋性和可控性。那么,如何才能有效降低LLM 的幻覺風險呢?其中,知識圖(Knowledge Graph,簡稱:KG)與LLM 的結合,藉由KG 來建立的行業或企業的數據地圖,來將各數據與其涵意(Semantics)連結起來,化解上述LLM 的三項缺點,因而有效減少LLM 的幻覺現象。

LLM 天生非常善解文句和人意,可以簡化知識圖中的復雜數據的查詢或檢索。由于知識圖是實體(Entity)相互關聯的描述的集合,提供了有關知識圖中數據的重要上下文(Context)和內容涵意,以便增強其響應速度和準確性。因而讓LLM 產生更精確、準確且與上下文相關的輸出,同時防止偏見和幻覺。

其典型的途徑是:使用RAG(檢索增強生成)技術。亦即,LLM 使用RAG 先檢索KG 來找到與用戶查詢最相關的知識。也可透過 基于圖的搜索(Graph Traversal) 或基于圖的嵌入檢索(Graph Embedding Retrieval) 來檢索KG內的信息。然后,把檢索到的KG知識作為上下文,反饋給LLM,于是LLM 就實現基于企業(或行業)內知識而生成響應了,有效降LLM幻覺,提高AI在企業應用的可信度。

3 LLM 協助KG:加速建構KG

剛才提到了,KG 是明確儲存豐富事實知識的數據結構,然而KG 的構建是費力又耗時的工作。于是,利用AI 模型(含LLM 等)來協助和加速建立KG,是一項高效的策略。例如,使用BERTopic 模型來從自由文本(Text)中萃取主題(Topic)作為候選實體(Entity);接著,使用 LLM(如ChatGPT)來抽取實體之間的關系(Links)。這種策略是充分利用LLM 的強大上下文理解能力來識別實體之間的語義關系,尤其在無監督式學習或少量標注數據的情況下,其效果特別好。

4 LLM加速建構KG的范例

典型的KG建構流程如下:

Step-1:識別實體(Entity)利用預訓練的AI 模型(例如BERTopic 等)從文本中識別出實體,例如食材、菜品、供貨商、烹飪方法等。尤其在缺乏充足的標注數據的應用情境中,BERTopic這種無監督式學習的模型能夠自動從文本中發掘隱含的語義結構。而且BERTopic 結合了Transformer 編碼器和聚類算法,更有利于捕捉文本中的語義關系,來生成較具可解釋性的主題,其更能夠映像到業務中具有代表性的概念或實體。經由AI 模型萃取出的候選實體只需要少許的人工審核,來確保候選實體符合業務需求,讓KG的建構更容易、更高效。簡而言之,此步驟的任務是,使用BERTopic 預訓練模型來提取種子實體列表,以指導KG 最相關的實體。這些種子實體保證了實體提取的高相關性,并為后續的三元組提取提供了較高精確度。

Step-2:抽取關系(Link)

LLM(如ChatGPT)具有強大上下文理解能力,可以精準識別出實體之間的語義關系。所以,LLM 很擅長基于上下文,而抽取實體之間的關系。例如:< 菜品包含某種食材> 或< 供貨商供應特定食材> 等。所以,使用LLM 來抽取實體之間的關系是可行且有效的,但為了提升準確度,可以設計提示詞(Prompt)限定關系類別,來提升準確性。還可以使用LoRA 等微調技術來讓LLM 更適合于企業(或行業)應用情境。此策略特別適合應用于企業KG 的構建,例如餐飲業的食材知識圖譜,能幫助企業從大量文本中自動化發掘菜品、食材、供貨商、烹飪方式等關系,從而提升數據結構化與應用價值。簡而言之,此步驟的任務是,使用LLM 進行候選三元組擷取。

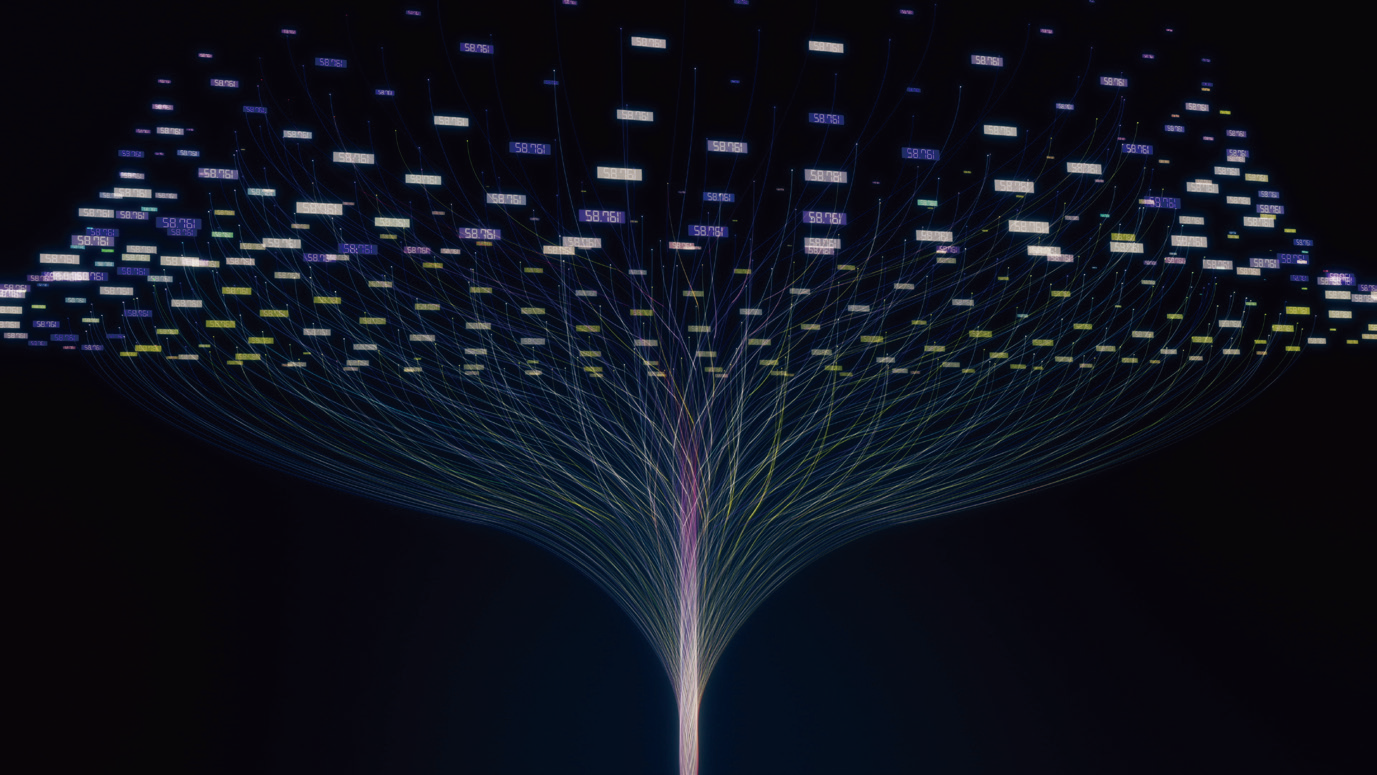

Step-3:建構KG

接著,將抽取出的實體和關系轉化為知識圖譜的節點(Node)與邊(Edge),形成初步的KG。也可以考慮使用圖數據庫(如Neo4j)來存儲和查詢它。簡而言之,此步驟的任務是,進一步整理并存儲萃取的三元組,并且運用圖數據庫(如 Neo4j)來查詢和可視化。

Step-4:KG融合

接著,將抽取出的實體和關系轉化為知識圖譜的節點(Node)與邊(Edge),形成初步的KG。也可以考慮使用圖數據庫(如Neo4j)來存儲和查詢它。最后,針對不同數據來源中同一實體的重復或歧義問題,需要利用實體對齊技術進行融合,確保知識圖譜的準確性和一致性。兩個實體之間提取的關系可能是沖突的、多樣化的或不正確的,這需要透過融合步驟來解決的。融合方法有助于調和沖突關系,有效地整合不同或不正確的關系,例如針對相同實體的不同表達進行融合和標準化,例如「西紅柿」和「西紅柿」歸為同一食材。并且可考慮與外部知識庫(如企業內部庫)連接,進行實體消歧或補全。簡而言之,此步驟的任務是,設計了新穎的融合模塊,該模塊提供了提取的知識的全局視圖,優化三元組、提升KG 質量。

5 結語

本文說明運用LLM 來協助建構KG 的目的及其典型的流程。例如,從自由文本(如食譜)中自動構建KG,包含:

● 實體(Entities):使用 BERTopic 萃取候選實體(Entities)。自動從文本中發現核心概念,例如食材、菜品名稱、烹飪方法等。

● 關系(Links):使用LLM 萃取關系(Links)。基于文本上下文,讓LLM自動識別實體間的關系。例如,食材與菜品的關系、烹飪方式與食材的關系等。

● 三元組(Triples):整理并存儲萃取的三元組(實體1,關系,實體2),構建KG,并運用圖數據庫來查詢和可視化。

綜上所述,使用BERTopic 來從無標注的文本自動提取主題,作為候選實體,能大幅減少人工成本。接著,LLM 來透過上下文理解來自動抽取關系,也減少手動標注需求。這種AI 模型的組合策略,能適用于建構不同領域的KG,如餐飲、醫療、供應鏈等。也具有可擴展性,若需要增添新類型的實體或關系,只需調整LLM 的提示詞或進行微調即可,也可以節省模型的訓練成本。所以,這是一種頗具有成本效益的AI 模型組合策略。

(本文來源于《EEPW》202503)

評論