凌華科技發布AES-100 邊緣智能服務器

凌華科技推出基于華為Ascend Atlas200的全新邊緣智能服務器AES-100,突破固有服務器的設計理念,采用分布式AI節點加彈性靈活的處理器設計方案,可在緊湊的1U空間內布置多路邊緣處理單元,也可以根據場景和需求不同搭配不同的CPU模塊,適用于廣泛的AI邊緣應用。

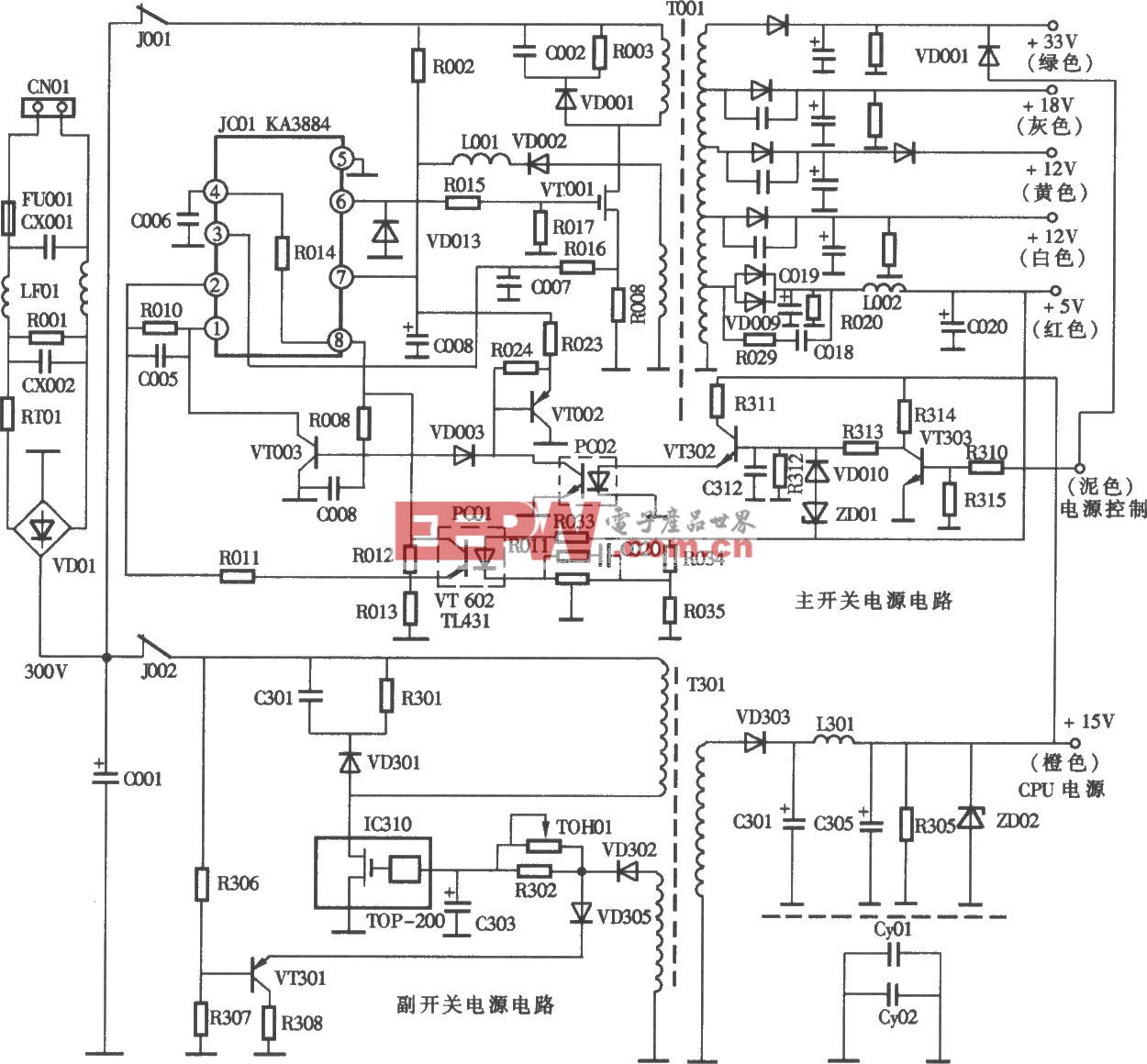

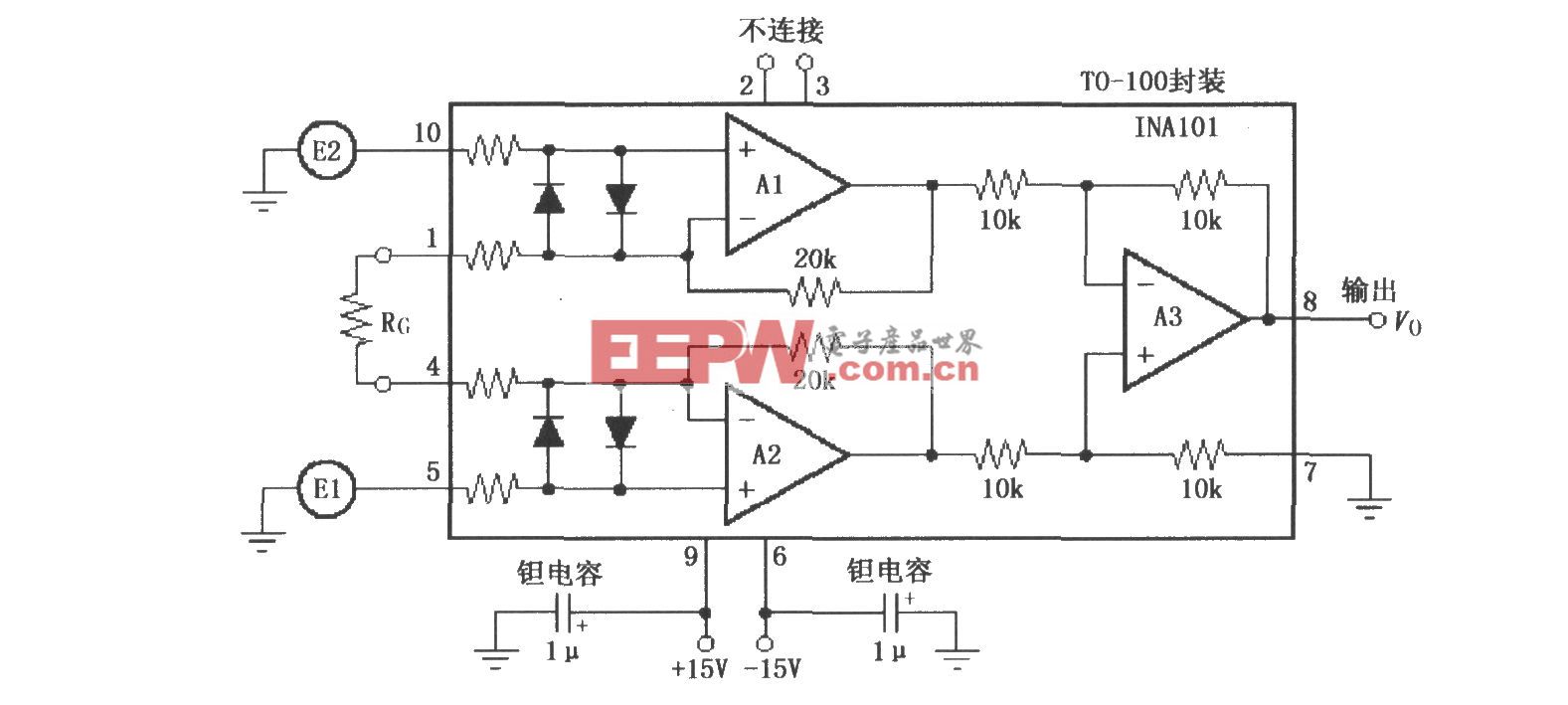

AES-100視頻分析服務器架構圖

產品亮點

· AES-100采用華為Atlas200邊緣智能計算核心,在1U空間內最多可支持24路Ascend310并行處理,最高具備了528TFLOPS算力;

· 每個Atlas-200可獨立部署任務,達到物理隔離部署不同的算法;

· 靈活多變的計算核心,可搭配Intel、兆芯、飛騰等多種處理器,適應不同的工作環境和要求,還可滿足國產化CPU加國產化AI模塊的需求;

· 提供高網絡吞吐能力,標配支持4路千兆網路和1路管理網口;

· 高可靠性,提供雙冗余電源;

· 單瓦算力優秀,整機可達到1.38TFLOPS/W;

與傳統的集中式算力架構相比,AES-100采用的分布式多路AI節點能夠有效地降低硬件成本。

算力架構 | 傳統集中式算力架構 | 分布式算力架構 |

產品特點 | CPU+GPU的異構計算,多個GPU通過PCIE鏈接到兩顆處理器,如:雙路4PU服務器、雙路8GPU服務器; | 每顆AI SOC芯片是一個完整的小算力節點,配置獨立的CPU、AI核心、編解碼核心、顯存、存儲和操作系統; |

CPU主要職責 | 負責數據預處理,如視頻軟解碼,CPU性能要求較高,根據GPU數量增加,CPU的性能也要增加; | 系統CPU:負責任務調度,對CPU性能要求不高; SOC CPU:負責數據預處理; 編解碼核心:負責視頻編解碼; |

內存主要職責 | 與GPU顯存之間數據交換,一般配置的內存容量要大于GPU的顯存總容量,GPU數量越多,需要配置的內存容量也越大; | 系統內存:負責任務調度,對內存容量要求不高; SOC 內存:相當于顯存,用于數據交換; |

成本對比 | CPU和內存的性能要求高,成本占比高 | CPU和內存的性能要求低,成本占比低 |

在高算力的場景下,采用分布式算力架構的硬件成本可大幅度下降。AES-100可以廣泛應用在城市道路對行人、機動車以及非機動車的特征結構化數據分析,可極大提高在海量視頻中對目標的查找速度;監所等特殊場合發生的一場行為進行檢測,并及時發出報警,有效提升視頻監控的價值,保障工作人員及在押人員的安全。

評論