基于數字集成電路的智能監控與識別追蹤系統*

*本項目獲得“2020全國大學生集成電路創新創業大賽”全國三等獎,西南賽區一等獎

本文引用地址:http://www.j9360.com/article/202104/424912.htm作者簡介:張健(1999—),男,漢,主要從事機器視覺,圖像處理,FPGA,RISC-V等方面的研究。

牛麗婷(2000—),女。王宜楠(1999—),女。

0 引言

近年來,隨著數字電子技術的不斷發展進步,基于圖像處理的自動監控技術逐漸走進大家的視野,公眾的安全與社會的穩定由此受到一定的保障。傳統的視頻監控系統主要是通過一些傳感器來采集數據,但需要有操作員長時間觀察顯示器,并通過人腦的判斷來對其進行相應識別,十分耗費精力。因此,引入智能監控與識別追蹤技術十分有必要。本設計應用移動偵測,一旦采集得的圖像數據中移動程度超過了檢測閾值,且判斷移動的物體是人而不是動物,系統即自動發出報警及時通知監測人員,并實現攝像頭的跟隨移動監控,從而大程度提高監測效率。

1 整體構架

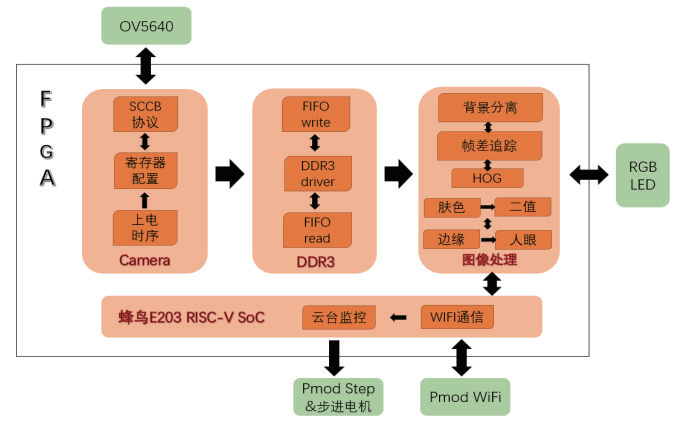

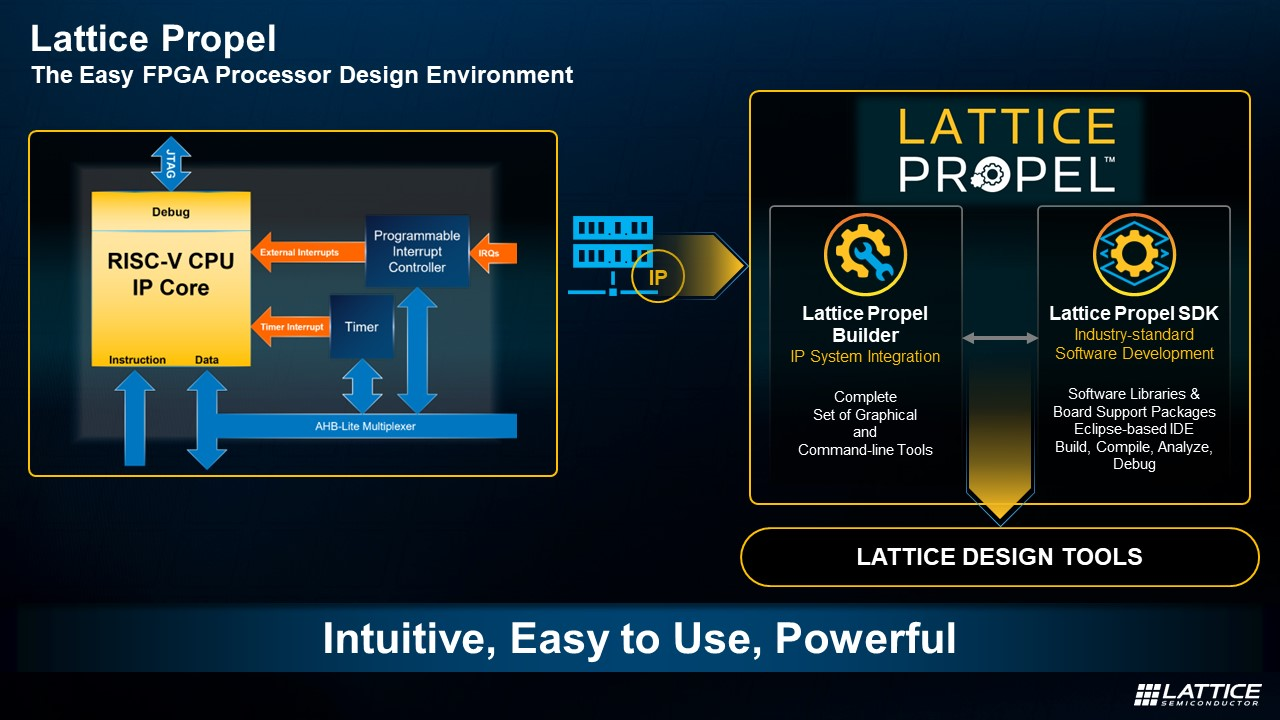

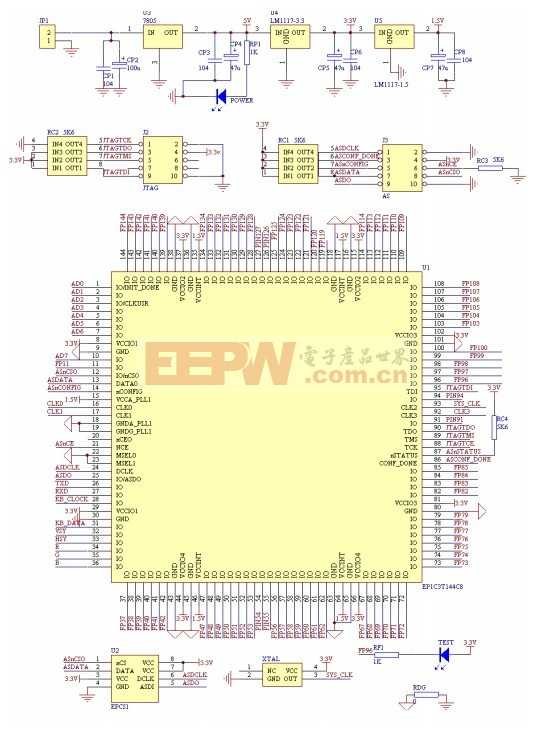

本團隊所設計的機器人的整體架構設計框圖如圖1所示。由圖可見,系統分為相互聯系的攝像頭模塊、DDR3 SDRAM 數據存儲與通信模塊、圖像處理模塊以及蜂鳥 E203 RISC-V SoC 片上系統。

圖1 系統整體架構設計圖

2 算法系統

2.1 背景差分法

2.1.1 原理介紹

背景差分法是先設定一張圖像作為背景圖像,然后通過對比背景圖像和接下來每一幀圖像數據的關系,設閾值做差分來分離出運動目標輪廓的一種方法。背景差分法是當前被廣泛采用的一種動態目標檢測方法。使用背景差分法檢測運動物體首先需要建立背景模板M(x,y),預先儲存一幀圖像畫面作為背景圖像,然后接下來采集到的每一幀圖像T(x,y) 要與背景模板M(x,y)進行減法運算,在設定一個合適的閾值P 的前提下,減出來的數值如果在閾值之內,則說明畫面靜止;如果超出了閾值,則表示這個像素點是運動目標的其中一個點,將兩種結果進行二值化,最終結果設為B(x,y)。[1]

背景差分法實現的關鍵是背景模型的獲取和更新。背景獲取算法通常要求在場景中存在運動目標的情況下獲取背景圖像,更新過程使背景能夠適應場景的各種變化和干擾, 如外界光線的改變, 背景中對象的擾動和固定對象的移動,陰影的影響等。一種典型的背景建模方法是用混合高斯模型描述背景圖像像素值的分布,目標檢測過程中判斷圖像的當前像素值是否符合該分布,若是被判為前景點,否則為背景點。同時根據新獲取的圖像,對背景圖像參數進行自適應更新。

在本設計中,我們將背景差分法與下文介紹的幀差法相結合,避免光照變化等情況對運動目標的漏檢和誤檢,獲得系統檢測的魯棒性。

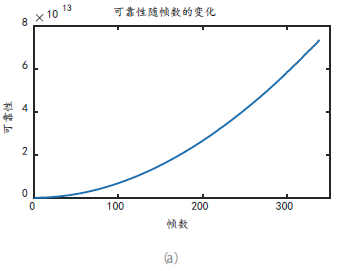

2.1.2 算法實現

在利用背景差分法來實現對運動區域的檢測時,需要通過連續k 幀的區域反饋識別物體的移動。本設計通過對實際圖像建模建立背景模板,將獲取的圖像數據與之比較,取約1 000 個不同時刻的像素值與原有數據求平均值,從而求出k 的最優解,即k 為多少時,能夠較好地吻合數據波動,并使k 盡可能地小,從而能確定取連續多少張背景圖時,能最迅速且最高效地實現背景差分法檢測運動物體(如圖2)。

備注:算法所指平均值為“實時平均值” avertime算術平均值稱為“真實平均值” averreal

圖 a:可靠性reliability = (aver ? aver ) time real2 Design & Application 工業控制

圖b:分別將表格第4 列和第5 列畫出,可直觀感受到對比

圖c:將第4、5 列作差得到測量誤差隨幀數的變化

圖 d:波動性volatility = probe2 ? avertime

2.1.3. 處理環境波動

對于一個相對安靜的場景,我們將諸如光線明暗變化和風吹葉動稱為環境的固有波動,屬于環境的固有屬性。而對于500 萬像素的OV5640 拍攝出來的圖像,像素點的小范圍波動稱為硬件波動。在處理一個運動場景,要想分離出有效的運動目標,就要克服環境固有波動和硬件波動。[2]

本設計充分統計了這兩種不可消除的波動分布,大致分為四個場景:光線明亮、光線昏暗、顏色多雜和純色背景。對于這四種不同場景,我們選取的閾值是不同的,充分提高監控設備的運動偵測敏感度的同時,盡量做到不誤報。

2.2 HOG特征提取算法

2.2.1. HOG特征原理介紹

方向梯度直方圖(Histogram of Oriented Gradient,HOG)特征是一種在計算機視覺和圖像處理中用來進行物體檢測的特征描述子。它通過計算和統計圖像局部區域的梯度方向直方圖來構成特征。Hog 特征結合SVM 分類器已經被廣泛應用于圖像識別中,尤其在行人檢測中獲得了極大的成功。[3]

1) 主要思想

在一副圖像中,局部目標的表象和形狀(appearance and shape)能夠被梯度或邊緣的方向密度分布很好地描述。(本質:梯度的統計信息,而梯度主要存在于邊緣的地方)。

2) 具體的實現方法:

首先將圖像分成小的連通區域,我們把它叫細胞單元。然后采集細胞單元中各像素點的梯度的或邊緣的方向直方圖。最后把這些直方圖組合起來就可以構成特征描述器。

3) 提高性能:

把這些局部直方圖在圖像的更大的范圍內(我們把它叫區間或block) 進行對比度歸一化(contrastnormalized),所采用的方法是:先計算各直方圖在這個區間(block)中的密度,然后根據這個密度對區間中的各個細胞單元做歸一化。通過這個歸一化后,能對光照變化和陰影獲得更好的效果。[4]

2.2.2 HOG特征提取算法的實現過程

HOG 特征提取方法就是將一個image(你要檢測的目標或者掃描窗口):

1) 灰度化(將圖像看做一個x,y,z(灰度)的三維圖像);

2) 采用Gamma 校正法對輸入圖像進行顏色空間的標準化(歸一化);目的是調節圖像的對比度,降低圖像局部的陰影和光照變化所造成的影響,同時可以抑制噪聲的干擾;

3) 計算圖像每個像素的梯度(包括大小和方向);主要是為了捕獲輪廓信息,同時進一步弱化光照的干擾。

4) 將圖像劃分成小cells(例如6×6 像素/cell);

5) 統計每個cell 的梯度直方圖(不同梯度的個數),即可形成每個cell 的descriptor;

6) 將每幾個cell 組成一個block(例如3*3 個cell/block),一個block 內所有cell 的特征descriptor 串聯起來便得到該block 的HOG 特征descriptor。

7) 將圖像image 內的所有block 的HOG特征descriptor串聯起來就可以得到該image(你要檢測的目標)的HOG 特征descriptor 了。這個就是最終的可供分類使用的特征向量了。

2.3 人眼檢測

2.3.1 原理介紹

通過對輸入圖像矩陣的處理,標記出人臉位置和眼睛的位置。

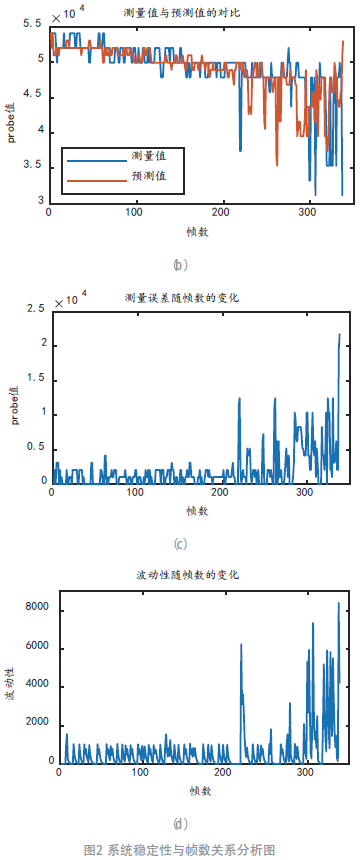

利用人臉幾何特征和sobel 邊緣檢測算法,對在有背景的灰度和彩色人臉圖像中自動檢測與定位人眼的操作。通過讀取輸入的圖片并將其存儲在RGB 矩陣內,接著對圖片人臉區域進行識別;然后采用sobel 算法對人臉區域進行邊緣提取,并在存儲邊緣輪廓的矩陣中結合臉部邊緣特征定位眼睛。

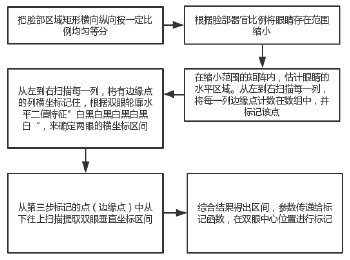

具體步驟如圖3。

圖3 人眼檢測部分功能框圖

2.3.2 程序設計

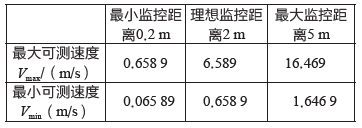

具體步驟如圖4。

圖4 眼部定位步驟流程

3 機械結構

3.1 攝像頭

OV5640 攝像頭主要由鏡頭、圖像傳感器、板載電路及下方的信號引腳組成。鏡頭部件包含一個鏡頭座和一個可旋轉調節距離的凸透鏡,通過旋轉可以調節焦距,正常使用時,鏡頭座覆蓋在電路板上遮光,光線只能經過鏡頭傳輸到正中央的圖像傳感器,它采集光線信號,然后把采集得到的數據通過下方的信號引腳輸出數據到外部器件。

3.2 WiFi

3.2.1 功能

實現實時WiFi 信息傳輸,為實現未帶口罩示警提供技術支撐。

3.2.2 特點

提供用戶按鈕,用于在模式切換后重置處理器。提供WiFi、低功耗藍牙和藍牙通信。

3.3 云臺監控

Pmod Step 板驅動步進電機,帶動攝像頭延長板底座隨之轉動,從而實現攝像頭的全方位跟隨監控。

4 系統整合報告

4.1 魯棒性

本團隊著手從反應速度、視野范圍和移動目標漏檢率等指標來衡量一個監控檢測入侵系統的性能優劣,并得出以下結論

4.1.1 監控設備反應速度較快

機器人采用OV5640 攝像頭,并使用Verilog 配置1 024×768 分辨率,像素時鐘pclk 為84 MHz,可計算出視頻幀率為65 Hz。

為消除環境波動給背景分離過程帶來的影響,我們取16 幀圖像為一次處理過程,計算出平均波動值并和閾值比較。因此,機器人處理一次環境波動所需時間 ,約為0.25 s,遠低于市面上的智能監控設備。

,約為0.25 s,遠低于市面上的智能監控設備。

4.1.2 視野范圍廣

此機器人所用OV5640 攝像頭監控角度大約為44.096 ° ( 誤差不超過5 °), 推薦可監控的直徑為0.2~5 m,理想距離為2 m。不難計算,機器人的視野范圍為0.162 2~4.054 m,理想距離下的視野寬度為1.622 m。在這樣較開闊的視野下,能有效保證監控到室內的每個角落,并能有良好的監控效果。

4.1.3 移動目標可監控范圍大

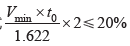

移動目標漏檢指標,是用來表征監控設備對高速和低速運動物體檢測能力。理想距離(2 m)下目標以速度Vmax 快速橫向穿過監控視野(1.622 m),所用時低于反應速度即不被機器人捕捉到,可計算得機器人在理想監控距離下的最大檢測速度Vmax=6.589 m/s。設靜止環境波動值為M0,則機器人所設閾值為120% M0。此時目標以速度Vmin 緩慢在監控視野內橫向移動,若目標移動導致的環境波動低于閾值,則可不被監控識別到。此時速度應滿足不等式 ,可計算出機器

,可計算出機器

人在理想監控距離下的最小檢測速度Vmin=0.658 9 m/s。同理可得最小和最大監控距離下的理論目標速度范圍,如表1。

表1 最小和最大監控距離下的理論目標速度

經實際測量,上述理論分析值可靠可信。由此可得,本機器人適用于絕大多數室內監控入侵場景,可檢測范圍囊括了全部目標可能移動速度,可以基本做到在較極端場景下的不漏檢,即有較高的性能魯棒性。

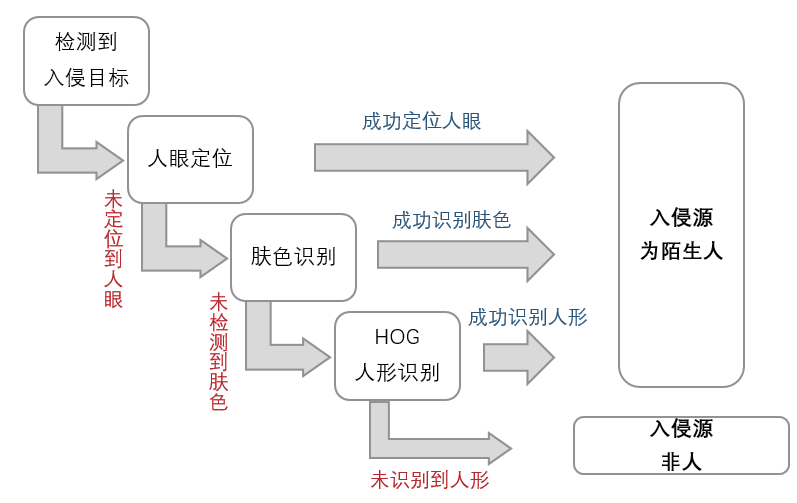

4.2 人與動物區分效果

本設計中對人和動物的區分部分采用了多重模塊同時作用,從而保證判斷結果更加準確。另外,口罩顏色識別模塊還能確定人臉的口罩佩戴規范情況。因此,本設計中多重確認的模塊共同發揮作用,使得人和動物的識別判斷更加準確和可靠( 如圖5)。

圖5 人與動物區分邏輯圖

4.3 調試最終效果

系統具有兩種運行狀態: 正常監控狀態和入侵報警監控狀態。正常監控狀態下不對監控視頻進行存儲和編碼傳輸,入侵報警監控狀態下具有觸發相應的報警裝置并記錄監控視頻和向上一級監控中心編碼傳輸監控視頻的功能。

4.3.1 LED燈光顯示--動態目標顯示

當采集得的圖像數據中檢測到移動物體時,本設計中紅色LED 燈亮起,提示偵測目標的出現。當上位機控制云臺監控電機向左轉動時,藍色LED 燈亮起;向右轉動時,綠色LED 燈亮起。

4.3.2 云臺轉動跟蹤--目標追蹤

本設計經調試可實現智能跟蹤、自動跟拍移動目標的功能,通過控制Pmod Step 板驅動步進電機,帶動攝像頭延長板底座隨之轉動,從而實現攝像頭的自動轉動跟蹤功能。

4.3.3 上位機接收信號并反饋--警報信息傳送

當采集得的圖像數據中被檢測有移動物體且對象為人時,WiFi 模塊發送警報信息傳遞至上位機,引起監測方的注意。

5 結語

作為微電子專業的大二學生,在參加這次全國大學生集成電路創新創業大賽中,除了專業能力的鍛煉,眼界視角的開闊外,給我們最大的影響其實是思想層面。

比賽中,偶然聽得指導教師“AI 已死”,“軟件定義芯片”的觀點,深感震撼,并對未來智能化的發展心馳神往。

我知道Robei 公司不僅僅是一家EDA 公司,也是一家芯片設計公司,我也知道了,本次賽題電路可重構,設備可重構,它真正的名字叫做“可重構機器人”,是真正的未來機器人競賽。我還知道,在華為被美國絞殺的今天,我們需要這樣的工具,而這樣的工具也需要我們去支持完善。

參考文獻:

[1] 圖像二值化[R/OL].https://baike.baidu.com/item/圖像二值化/1748870?fr=aladdin.

[2] SiFive,Inc.SiFive Freedom E310 Arty FPGA Dev Kit Getting Started Guide[Z].2017:5-12.

[3] 數字集成電路設計描述與仿真[EB/OL].https://m.book118.com/html/2017/0726/124465246.shtm?from=mip.

[4] MARGOLIS M.Arduino權威指南[M].楊昆云,譯.2版.北京:人民郵電出版社,2015.

(本文來源于《電子產品世界》雜志2021年3月期)

評論